1. Introduction

Dans le contexte éducatif, l’autorégulation fait référence à la manière dont les apprenant⸱e⸱s « activent et maintiennent systématiquement leurs cognitions, motivations, comportements et affects en vue d’atteindre leurs objectifs » (Schunk & Greene, 2018, p. 1). Ce concept qui inclut les compétences métacognitives, motivationnelles et comportementales met en évidence différentes stratégies d’apprentissage. Les recherches de Zimmerman et Pons (1986) démontrent que ces stratégies jouent un rôle déterminant dans la réussite scolaire des élèves. Ces auteur⸱e⸱s révèlent que les apprenant⸱e⸱s ayant un haut niveau de réussite scolaire utilisent de manière plus significative les stratégies d’apprentissage autorégulées par rapport à ceux ayant des niveaux de réussite inférieurs.

Afin de mesurer l’autorégulation dans des contextes d’apprentissage réels, Zimmerman et Martinez-Pons (1986) ont développé le Self-Regulated Learning Interview Schedule (SRLIS). Cet outil, sous forme d’entretien structuré, explore l’utilisation de quatorze catégories de stratégies d’apprentissage autorégulées par les élèves. Ces dernières et ces derniers décrivent les stratégies d’apprentissage dans plusieurs contextes. Dans le cadre de cours universitaires, il nous est demandé d’utiliser le test SRLIS pour identifier et analyser les stratégies d’apprentissage autorégulé utilisées par deux étudiant⸱e⸱s.

2. Instrument commun: Self-Regulated Learning Interview Schedule (SRLIS)

2.1 Description de l’outil

Le Self-Regulated Learning Interview Schedule (SRLIS) est un outil conçu par Zimmerman et Martinez-Pons (1988) pour évaluer l’utilisation des stratégies d’apprentissage autorégulées chez les élèves. Il se trouve parmi les premiers instruments permettant de mesurer l’apprentissage autorégulé des apprenant⸱e⸱s. Cet entretien structuré met en lumière les différentes stratégies d’autorégulation qu’ils utilisent dans divers contextes scolaires.

Le SRLIS identifie ainsi quatorze catégories de stratégies d’apprentissage autorégulé, définies à partir de la littérature scientifique (Zimmerman et Martinez-Pons, 1986). Ces catégories mettent en évidence les processus personnels, comportementaux et environnementaux des différent⸱e⸱s apprenant⸱e⸱s (cf. annexe 7.1). L’entretien explore l’utilisation de ces stratégies dans six contextes d’apprentissage distincts et fréquents, aussi bien qu’en situation de classe qu’en situation d’apprentissage à l’extérieur de l’école (Zimmerman et Martinez-Pons, 1988).

Le SRLIS prend la forme d’un entretien structuré. Les élèves sont interrogé⸱e⸱s sur les méthodes qu’ils utilisent dans chaque contexte pour gérer leur apprentissage. Les réponses sont libres pour éviter de suggérer des stratégies. Si l’élève ne donne pas de réponse spontanée, l’intervieweur⸱euse utilise des questions de relance telles que « Que faites-vous si vous avez des difficultés ? ». Cette technique permet de recueillir des informations plus complètes qui pourront ensuite être identifiées parmi les stratégies citées ci-dessus.

2.2 Description de l’échantillon

L’échantillon se compose de deux participant.e.s aux profils diversifiés :

- Participante 1 : Il s’agit d’une femme de 24 ans, actuellement étudiante en deuxième année de Master en enseignement spécialisé. Elle est titulaire d’un Bachelor en enseignement primaire réalisé à la HEP.

- Participant 2 : Il s’agit d’un homme de 27 ans, qui termine ce semestre ses études à la HEP, en raison d’un prolongement de son cursus. Actuellement, il enseigne en 7H à un taux d’activité de 80 %.

2.3 Description de la méthodologie

2.3.1 Collecte des données

L’entretien structuré mené dans cette étude visait à explorer l’utilisation des stratégies d’apprentissage autorégulé chez les participant⸱e⸱s. L’entretien a été conçu pour recueillir des réponses libres, évitant ainsi d’influencer les participants. Les participant⸱e⸱s ont été invité⸱e⸱s à décrire leurs méthodes d’autorégulation dans les six contextes. Après l’identification de chaque stratégie, ils devaient évaluer la fréquence de leur utilisation sur une échelle de Likert de 1 à 4 (rarement, occasionnellement, fréquemment, la plupart du temps). Les deux entretiens ont été enregistrés et retranscrits à l’aide de l’outil de retranscription inclus à Microsoft Word.

2.3.1 Traitement des données

Les stratégies identifiées ont été classées selon les quatorze catégories de Zimmerman et Martinez-Pons (1988), et une catégorie « autres » a été ajoutée pour les réponses ne pouvant pas être classées. Ce processus a été réalisé sur format papier, en relevant les catégories avec des feutres de différentes couleurs. Trois procédures spécifiques ont été utilisées pour l’analyse : strategy use (SU), strategy frequency (SF) et strategy consistency (SC) (Zimmerman et Martinez-Pons, 1988).La première procédure (SU) servait à déterminer si une stratégie avait été mentionnée au moins une fois dans les six scénarios. La seconde (SF) évaluait le nombre d’occurrences des stratégies selon les contextes. Enfin, la troisième (SC) mesurait la régularité d’utilisation des stratégies, notamment grâce aux relances pour obtenir des précisions sur leur fréquence.

2.4 Présentation des résultats

En annexe se trouve la présentation des résultats selon les stratégies SU et SF (cf annexe 7.2), ainsi qu’un tableau proposant les stratégies SC avec l’explication de la fréquence de chaque stratégie (cf.annexe 7.3). Bien que les deux participant⸱e⸱s aient eu recours à des stratégies similaires, des différences apparaissent concernant la nature et la fréquence de leur utilisation.

La participante 1 a montré une utilisation régulière et diversifiée des stratégies, relevant une approche systématique et structurée de son apprentissage. Les fréquences élevées de 4 ont été observées pour l’organisation et la structuration de l’environnement. La participante insiste sur la nécessité de travailler dans un environnement calme et adapté : « Dans les cafés comme ça, j’arriverais pas à travailler, il y a aussi trop de stimulis. Même à la bibliothèque, c’est compliqué car il y a toujours des gens qui rentrent et qui ressortent, je suis toujours en train de regarder. » Elle planifie fréquemment ses révisions pour être prête aux examens et organise ses tâches en début de semaine. Occasionnellement, elle utilise une application pour se fixer des objectifs et gérer son travail de manière efficace. Elle analyse sa motivation et adapte sa méthode de travail en conséquence. Elle a souligné l’importance de donner du sens aux tâches, ce qui facilite son apprentissage.

Le participant 2 utilise d’autres formes de stratégies. En effet, il effectue son travail à la dernière minute, rapidement : « J’essaie de le faire le plus rapidement possible, de faire en sorte que la tâche soit finie. » Il admet que ses travaux sont parfois « un peu bâclés » et reconnaît travailler principalement pour obtenir une note suffisante. Si les devoirs ne sont pas notés, il ne les réalise pas. Il ne prend que très peu de notes, s’appuyant sur le travail des autres pour réviser. La stratégie de « recherche d’aide sociale » est omniprésente pour lui, apparaissant dans quatre contextes différents. Malgré cela, il reste conscient de ses méthodes et parvient à respecter les délais.

2.5 Discussion de l’outil : avantages et limites

L’outil SLRIS présente plusieurs avantages. Grâce à des contextes précis et à des questions de relance, il fait émerger chez l’étudiant⸱e un large éventail de stratégies d’autorégulation. Cela permet d’analyser, d’adapter et d’améliorer son fonctionnement. De plus, l’étudiant⸱e est placé dans des situations concrètes, ce qui lui permet de se projeter et de mieux exprimer sa manière de fonctionner. L’outil propose une classification en quatorze catégories, offrant une vision nuancée des pratiques d’autorégulation. Cette diversité couvre un large spectre de stratégies et met en avant des aspects que d’autres questionnaires plus généraux pourraient négliger.

Par l’analyse des résultats, plusieurs limites ont été relevées. Les scénarios suggérés par le SRLIS ne conviennent pas systématiquement à tous les apprenant⸱e⸱s. Dans mon expérience, l’exemple tiré de l’histoire des droits civiques a déstabilisé les répondant⸱e⸱s. J’ai donc opté pour des exemples plus familiers, tels que l’éducation spécialisée ou la didactique.

Bien que l’outil dispose de quatorze catégories, plusieurs réponses se sont retrouvées dans la rubrique « autres », rassemblant ainsi des stratégies très différentes qui n’ont pas forcément de rapport entre elles. Il serait donc pertinent d’ajouter davantage de catégories. De plus, je trouve qu’elles ne sont pas toujours adaptées à une société en pleine expansion technologique. Par exemple, une catégorie pourrait concerner les intelligences artificielles.

Aussi, j’ai éprouvé des difficultés à classer certaines réponses entre « répétition et mémorisation » ou « examen des dossiers ». Pour assurer la cohérence, j’ai opté pour « répétition et mémorisation » en cas d’hésitation. Ce choix souligne la part de subjectivité inhérente à ce processus.

J’ai constaté des limites dans la présentation des résultats. Des éléments de nature très différente peuvent apparaître dans la même catégorie. Par exemple, l’étudiante 1 se prépare toujours plusieurs semaines à l’avance pour un examen, tandis que l’étudiant 2, bien qu’il planifie son travail plusieurs semaines avant l’échéance, prévooit d’étudier deux jours avant la date. Les deux affichent alors une fréquence élevée de planification, mais leurs stratégies sont différentes, tout comme leurs effets.

Les scénarios proposés sont longs et les répondants se sont sentis parfois perdus dans l’énoncé. Enfin, les deux participant⸱e⸱s peinaient à distinguer les contextes 2, 3 et 5, tous associés aux devoirs à la maison.

3. Instrument du groupe : Marburg Self-Regulation Questionnaire for Teachers (MSR-T)

3.1 Description de l’outil

Le Marburg Self-Regulation Questionnaire for Teachers (MSR-T) est un outil psychométrique conçu pour évaluer les compétences d’autorégulation des enseignant⸱e⸱s dans différents contextes professionnels : l’enseignement, la motivation personnelle, les soins personnels et la communication. L’enseignement englobe des aspects variés tels que la préparation des cours, la gestion de classe, l’évaluation des élèves et la relation pédagogique. La motivation personnelle met en évidence la capacité à maintenir son engagement face aux défis et à la diversité des tâches du métier. Les soins personnels renvoient aux stratégies mises en place pour préserver le bien-être physique et mental. Enfin, la communication inclut les interactions professionnelles de l’enseignant⸱e avec les élèves, les parents, les collègues et les supérieur⸱e⸱s. Pour chacun de ces contextes, le MSR-T s’appuie sur trois processus fondamentaux de l’autorégulation : la planification, le monitoring (suivi) et la réflexion.

Développé à partir d’une littérature scientifique rigoureuse et ciblée, notamment les travaux de Zimmerman (2000) et Pintrich (2000), le MSR-T s’inspire également d’instruments existants tels que le Hannover Self-Regulation Inventory (HSRI) et l’Allgemeine Verhaltens- und Erlebensmuster (AVEM) (Li Sanchez & Schwinger, 2023). Grâce à deux études scientifiques, le questionnaire a évolué de 79 à 27 items, sélectionnés pour leur pertinence, fiabilité et validité.

Ces 27 items mettent en lumière les stratégies adaptatives et non adaptives utilisées par les enseignant⸱e⸱s dans leurs processus d’autorégulation. Le MSR-T constitue ainsi un outil précieux pour identifier les forces et les pistes d’amélioration des enseignant⸱e⸱s, facilitant leur orientation vers des formations et des renforcements ciblés pour les aider à se développer efficacement dans divers contextes professionnels.

3.2 Description de la méthodologie

3.2.1 Collecte des données

Lors de la création du questionnaire, deux contextes spécifiques ont été mobilisés : l’enseignement et la motivation personnelle. Cette sélection permet une analyse ciblée et facilite l’évaluation des items dans les deux situations. Un questionnaire a été créé à l’aide de Google Forms. Chaque étudiant⸱e a été invité⸱e à répondre à deux séries distinctes concernant l’enseignement et la motivation. Les différents contextes étaient expliqués. Chaque série comprenait les 27 items du questionnaire initial, formulés sous forme de phrases déclaratives, à évaluer sur une échelle de Likert à cinq points allant de 1 (pas du tout d’accord) à 5 (tout à fait d’accord). Les deux étudiant⸱e⸱s ont répondu en ligne, ce qui a permis une collecte rapide et centralisée des réponses.

3.2.2 Traitement des données

Les réponses ont été regroupées dans un tableau synthétique et les analyses ont été effectuées à l’aide d’Excel. Les principales étapes du traitement des données comprenaient :

- Calcul des moyennes : Une moyenne a été calculée pour chaque processus (planification, monitoring, réflexion), sur la base des scores de 1 à 5.

- Séparation des items adaptatifs et non adaptifs : Les deux types d’items ont été analysés séparément afin d’éviter tout biais dans les résultats.

- Création de graphiques : Différents graphiques ont été réalisés pour visualiser les résultats et identifier les tendances

Les résultats obtenus, ainsi que les graphiques associés, sont présentés dans le chapitre suivant.

3.3 Présentation des résultats

Le premier graphique ci-dessous présente les résultats de chaque item (adaptatif et non adaptatif) obtenus par les deux étudiant⸱e⸱s dans les deux contextes étudiés (enseignement et motivation personnelle). Les tableaux détaillant les scores du processus « planification ». Les tableaux présentant les deux autres processus sont disponibles en annexe (cf. annexe 7.4). Les résultats démontrent des tendances similaires.

Tableau 1

Processus de planification (MSR-T)

Ce graphique met en évidence que les résultats de l’étudiante 1 se situent principalement autour de 3 (correspond à « neutre ») sur l’échelle de Likert, aussi bien pour les items adaptatifs que pour les items non adaptatifs. Les scores pour les stratégies adaptatives dépassent rarement le niveau 3, traduisant un usage limité de ces compétences.

En revanche, l’étudiant 2 obtient des résultats significativement meilleurs. Ses scores se situent majoritairement à 5 (correspond à « tout à fait d’accord ») pour les items adaptatifs et à 1 (correspond à « pas du tout d’accord ») pour les items non adaptatifs, reflétant une utilisation cohérente des stratégies d’autorégulation positives et une absence notable de recours aux stratégies inadaptées.

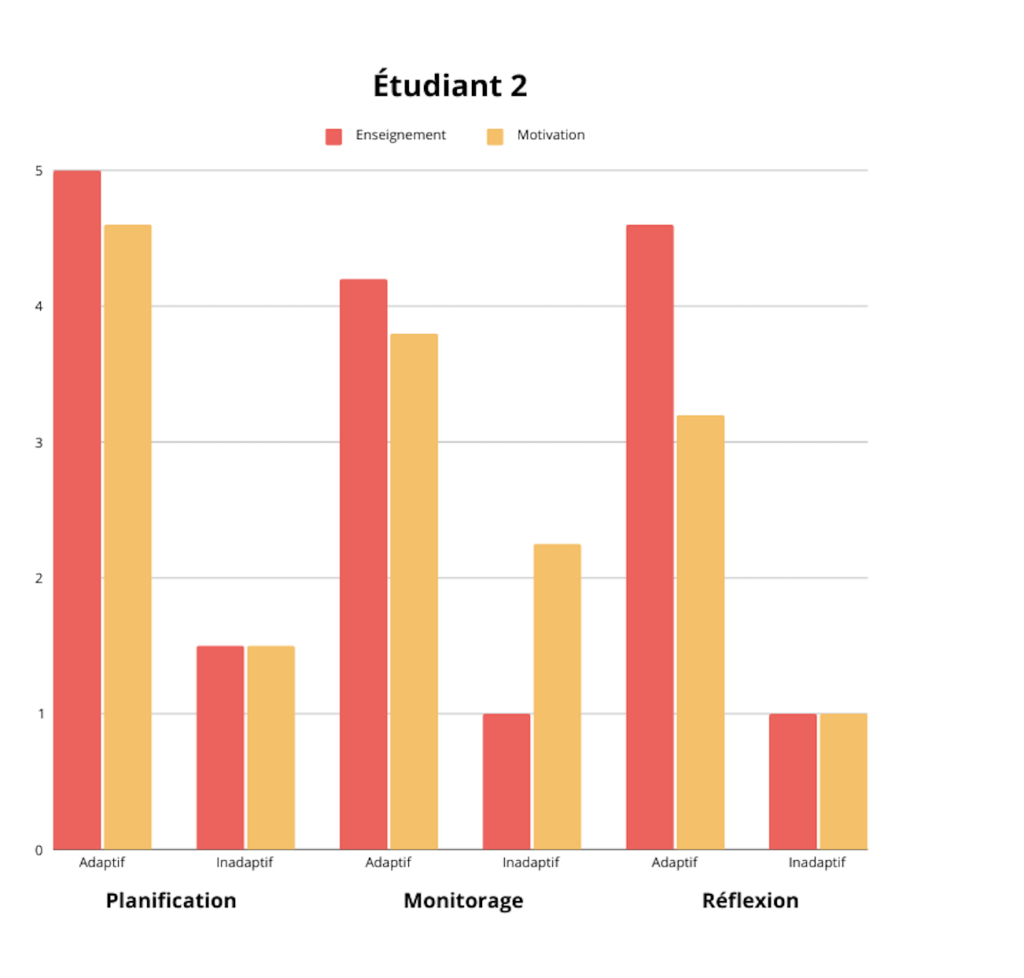

Les deux graphiques ci-dessous présente les moyennes des stratégies adaptatives et non adaptatives pour chaque processus (planification, monitoring et réflexion). Ces données, regroupées en deux tableaux distincts pour chaque étudiant, confirment les résultats observés précédemment. Pour l’étudiante 1, les moyennes oscillent entre 2 (correspond à « plutôt pas d’accord ») et 3 (correspond à « neutre ») traduisant une utilisation modérée des stratégies. En comparaison, l’étudiant 2 affiche une forte variabilité entre les scores adaptatifs élevés et les scores non adaptatifs faibles.

Ce graphique met également en avant une proximité des résultats entre les deux contextes (enseignement et motivation) pour chaque étudiant.

Tableau 2

Moyenne des résultats étudiant 1

Tableau 3

Moyenne des résultats étudiant 2

Un autre tableau (7) répertoriant tous les résultats de manière détaillée se trouve en annexe (cf. annexe 7.5).

3.1 Discussion de l’outil : avantages et limites

L’étudiante 1 répond majoritairement avec un score de 3 (neutre) sur l’échelle de Likert. Sur les 54 items (27 par contexte), 24 réponses sont marquées comme neutres. Cette tendance de neutralité pourrait refléter une incertitude ou une incompréhension des items. En effet l’étudiante pourrait utiliser une réponse intermédiaire pour éviter de se positionner. Ce constat soulève des questions sur la formulation et la clarté des items. La comparaison avec l’étudiant 2 renforce ce point. Bien que ce dernier ait des réponses plus polarisées, il utilise aussi parfois la réponse neutre, notamment pour des items comme « face à des problèmes/obstacles, je pense d’abord à toutes sortes de choses qui n’ont rien à voir avec eux »Ainsi, certains items semblent être trop généraux et pourraient être mal interprétés.

Les réponses des deux étudiant⸱e⸱s montrent une grande variation, mettant en évidence des interprétations différentes des items. Par exemple, dans « je peux spécifier des objectifs intermédiaires significatifs », ils⸱elles ont des résultats complément opposés. Ces écarts soulèvent la question de la clarté et de la précision des items. Certains items pourraient être trop vagues, laissant place à des interprétations basées sur l’expérience personnelle des répondant⸱e⸱s. Les différences dans les expériences et les perceptions de chaque étudiant⸱e pourraient également influencer la compréhension des questions, indiquant un potentiel problème de validité.

Les résultats montrent une grande similarité entre les deux contextes évalués : enseignement et motivation personnelle. Cela pourrait indiquer que les participant⸱e⸱s ne perçoivent pas clairement la distinction entre ces contextes. Ce problème a été illustré par l’étudiant 2, qui a initialement répondu au questionnaire sans comprendre la différence entre les deux contextes. Après l’avoir expliqué les deux contextes, il a répondu à nouveau au questionnaire. Ce constat met en lumière une possible généralisation excessive des items, qui pourraient ne pas être assez spécifiques ou adaptés pour différencier les contextes de manière claire.

Certaines réponses, en particulier pour l’étudiante 1, montrent des incohérences entre des items appartenant au même processus. Par exemple, elle a des résultats complétement opposées à « je peux diriger mon attention sur des aspects pertinents pour la tâche » et à « je me donne intérieurement des instructions sur la façon dont je souhaite faire quelque chose. »

Ces différences pourraient être dues à une mauvaise interprétation des items. Cela pose une question de validité : les items évaluent-ils vraiment les mêmes compétences ? Ou est-ce que les items sont si spécifiques qu’ils évaluent des compétences distinctes ? Ces observations pourraient indiquer une force (évaluation fine) ou une faiblesse (manque de cohérence interne).

Les résultats montrent une proximité de réponses entre les trois processus (planification, monitoring, réflexion) pour chaque étudiant. Cela soulève aussi des interrogations sur la capacité du questionnaire à différencier efficacement chaque processus. Les items permettent-ils de capter des différences significatives entre les processus ?

4. Comparaison des outils SRLIS/MSR-T

La pratique des deux outils révèle des différences majeures. Le SRLIS évalue les stratégies d’apprentissage autorégulé chez les étudiant⸱e⸱s dans des contextes éducatifs variés, tandis que le MSR-T examine les compétences d’autorégulation des enseignant⸱e⸱s dans des contextes professionnels. Le SRLIS est basé sur des entretiens structurés avec des réponses libres. Malgré un traitement quantitatif, elle offre une approche qualitative approfondie, permettant de découvrir des informations nouvelles. En revanche, le MSR-T est un questionnaire fermé, évaluant des items sur une échelle de Likert. Le SRLIS explore 14 catégories spécifiques de stratégies, alors que le MSR-T se concentre, à travers 27 items, sur trois processus clés : planification, monitoring et réflexion.

Les résultats montrent des incohérences marquées entre les deux outils. La participante 1 a de très bons résultats au SRLIS, mais de faibles scores au MSR-T. Tandis que le participant 2 a de faibles résultats au SRLIS, mais des scores élevés au MSR-T.

Le SRLIS met en évidence des stratégies personnelles. Par exemple, la participante 1 démontre une forte organisation et une attention soutenue dans l’accomplissement des tâches. Pourtant, dans le MSR-T, des items liés à l’organisation et l’attention tels que « je peux spécifier des objectifs intermédiaires significatifs » ou « je peux diriger mon attention sur des aspects pertinents » obtiennent des scores faibles. Ces écarts, qui se retrouvent dans d’autres situations, soulèvent des interrogations. Est-ce que les différentes limites identifiées par les deux outils influencent ces résultats ? Est-ce que les items du MSR-T sont trop spécifiques et ne peuvent pas être mises en relation avec les catégories du SRLIS ?

Pour le participant 2, les divergences sont similaires. Le SRLIS montre un travail bâclé, une dépendance envers ses camarades, une exécution à la dernière minute, et une incapacité à mettre en œuvre une approche stratégique à long terme. Cependant, le MSR-T attribue des scores élevés à des items tels que « adopter une approche stratégique pour atteindre ses objectifs ». Cet item pourrait relever son manque de clarté, ne précisant pas la nature de la stratégie. Ainsi, cela mettrait en lumière les limites du MSR-T à refléter les compétences d’autorégulation.

5. Conclusion

Bien que les outils soient très différents, les résultats de l’analyse comparative entre eux sont surprenants. Il serait pertinent de confronter ces résultats aux étudiant⸱e⸱s pour mieux comprendre cette dynamique.

Dans cette optique, une discussion téléphonique a été menée après la collecte des données pour recueillir des retours qualitatifs sur l’utilisation des outils. Les deux participant⸱e⸱s ont souligné que le test SRLIS était intéressant et leur avait permis de prendre conscience de certaines de leurs stratégies d’autorégulation. Cependant, ils ont également mentionné des difficultés à comprendre certains contextes.

Voici quelles pistes d’amélioration pour SRLIS :

- Adapter les contextes : personnaliser les scénarios en fonction des contextes spécifiques à chaque apprenant⸱e.

- Structurer les items : reformuler les énoncés pour les rendre plus clairs et distincts les uns des autres.

- Clarifier les catégories : préciser les catégories pour éviter le chevauchement des réponses. Créer de nouvelles catégories pertinentes, notamment en lien avec l’évolution de la société (ex. technologie). Il serait également possible d’introduire des sous-catégories.

- Prendre en compte la diversité des pratiques : identifier et préciser comment les stratégies d’une même catégorie peuvent être appliquées différemment (ex. planifier longtemps à l’avance vs tout faire en dernière minute) et introduire une évaluation de leur efficacité et pertinence.

Concernant le test MSR-T, les participant⸱e⸱s ont signalé des problèmes liés à la différenciation des contextes et des trois processus. « Je ne comprenais pas bien la différence entre la motivation et l’enseignement », a expliqué la participante 1. Le participant 2 a trouvé les contextes trop généraux. Ils ont également mentionné que certains items étaient flous, ce qui les poussait parfois à répondre au hasard. Ces retours soulignent les limites du questionnaire en termes de validité et de fiabilité.

Pistes d’amélioration pour le MSR-T :

- Clarifier et contextualiser les items : les rendre plus précis pour éviter les ambiguïtés, même si cela limite leur transférabilité à différents contextes.

- Préciser les contextes : réduire leur généralité et proposer des descriptions plus ciblées, afin d’éviter des interprétations trop variées.

- Améliorer la différenciation des processus : adapter les items à chaque processus et fournir des explications supplémentaires.

6. Bibliographie

- Borkowski, J. G., Chan, L. K. S. et Muthukrishna, N. (2000). A process-oriented model of metacognition: Links between motivation and executive functioning. In G. Schraw et J. C. Impara (dir.), Issues in the measurement of metacognition (p. 1-41). Buros Institute. https://digitalcommons.unl.edu/burosmetacognition

- Li Sanchez K, Schwinger M. (2023). Development and Validation of the Marburg Self-Regulation Questionnaire for Teachers (MSR-T). Trends in Higher Education, 2(3), 434-461. https://doi.org/10.3390/higheredu2030026

- Pintrich, P.R. (2000) The role of goal orientation in self-regulated learning. In Handbook of Self-Regulation; Boekaerts, M., Pintrich, P., Zeidner, M., Eds.; Academic: San Diego, CA, USA, pp. 451–502.

- Schunk, D. H., & Greene, J. A. (2018). Historical, contemporary, and future perspectives on self-regulated learning and performance. In D. H. Schunk & J. A. Greene (Eds.), Handbook of self-regulation of learning and performance (pp. 1–15). Routledge/Taylor & Francis Group.

- Usher, E. L., & Schunk, D. H. (2018). Social cognitive theoretical perspective of self-regulation. In D. H. Schunk & J. A. Greene (Eds.), Handbook of self-regulation of learning and performance (pp. 19–35). Routledge/Taylor & Francis Group.

- Zimmerman, B. J., & Pons, M. M. (1986). Development of a structured interview for assessing student use of self-regulated learning strategies. American Educational Research Journal, 23(4), 614–628. https://doi.org/10.2307/1163093 (PDF sur Moodle)

- Zimmerman, B. J., & Martinez-Pons, M. (1988). Construct Validation of a Strategy Model of Student Self-Regulated Learning. Journal of Educational Psychology, 80(3), 284–290. https://doi.org/10.1037/0022-0663.80.3.284

- Zimmerman, B. J., & Martinez-Pons, M. (1990). Student differences in self-regulated learning: Relating grade, sex, and giftedness to self-efficacy and strategy use. Journal of Educational Psychology, 82(1), 51–59. https://doi.org/10.1037/0022-0663.82.1.51 Zimmerman, B.J. Attaining self-regulation: A social cognitive perspective. In Handbook of Self-Regulation; Academic Press: Cambridge, MA, USA, 2000; pp. 13–39.