Auteur-tric-e-s : Delia Chiarani

Introduction

L’autorégulation de l’apprentissage est entendue comme « la manière dont les apprenants activent et maintiennent systématiquement leurs cognitions, leurs motivations, leurs comportements et leurs affects, en vue d’atteindre leurs objectifs. » (Schunk & Greene, 2018, p.1). Son importance se voit surtout dans les degrés supérieurs d’enseignement, où l’apprentissage se passe souvent dans des environnements déstructurés. Ici, la maîtrise académique est liée au processus de l’autorégulation (B. Zimmerman & Martinez-Pons, 1986). Les stratégies d’auto-apprentissage sont conçues en tant qu’actions visant à l’acquisition des informations et / ou des compétences qui impliquent l’agence, les objectifs et l’instrumentalité perçue par l’individu (B. Zimmerman & Martinez-Pons, 1986). Plus en détail, une stratégie est définie par Dinsmore (2018) comme une connaissance procédurale, qui est caractérisée par son orientation vers un but précis et par les efforts exercés par l’individu. Ceci comprend donc les connaissances possédées, la possibilité et la capacité de les transférer à d’autres contextes, et la capacité de transformer les problèmes (Dinsmore, 2018). Les stratégies d’auto-apprentissage s’inscrivent en fait dans le cadre du concept d’autorégulation de l’apprentissage, évalué comme essentiel dans la guidance de l’apprentissage formel et dans l’auto-éducation et la mise à jour de ses propres connaissances après l’école (Boekaerts, 1997).

Par ce travail, je vise à l’exploration de l’usage des stratégies d’auto-apprentissage de deux élèves universitaires et à l’évaluation de leur sentiment d’auto-efficacité d’apprentissage par le biais de deux outils : le SRLIS et le SELF.

Self-Regulated Learning Interview Schedule (SRLIS)

Description de l’outil

Le premier outil utilisé dans le cadre de cette recherche est le SRLIS, à savoir le « Self-Regulated Learning Interview Schedule », ou « Protocole d’entretien sur l’apprentissage autorégulé » en français. Il s’agit d’un des premiers instruments qui vise à évaluer l’apprentissage autorégulé des apprenant-e-s vu en tant qu’aptitude et non que processus. La forme est celle d’un entretien court et structuré, dans lequel les interviewé-e-s expliquent leurs réactions face à six scénarios d’apprentissage naturels qui pourraient stimuler l’autorégulation. Les réponses cherchées sont situées, spontanées. Les comportements des apprenant-e-s ressortis pendant l’entretien reflètent des stratégies autorégulées connues, classées selon 14 groupes (Winne & Perry, 2000; B. Zimmerman & Martinez-Pons, 1986, 1988).

Les six scénarios d’apprentissage utilisés par cette recherche ont été traduits de l’anglais (B. Zimmerman & Martinez-Pons, 1988) et adaptés au contexte universitaire. Ils touchent plusieurs aspects de l’apprentissage autorégulé, comme la planification de la rédaction d’un texte, la révision pour s’en souvenir d’une leçon, la révision avant un examen, les devoirs à la maison, la motivation et l’engagement, et le travail en dehors des cours. Les 14 types de stratégies d’apprentissage autorégulé ont été traduites de l’anglais aussi, et sont les suivantes : autoévaluation ; organisation et transformation ; fixation d’objectifs et planification ; recherche d’informations ; tenue de registres et suivi ; structuration de l’environnement ; conséquences personnelles ; répétition et mémorisation ; recherche d’aide sociale (pairs, enseignant-e-s, adultes) ; examen des dossiers (tests, notes, examens). Une 15e catégorie (« Autres ») a été introduite pour pouvoir classer toute réponse qui indique un comportement d’apprentissage initié par d’autres personnes et toute réponse verbale non claire.

Description de l’échantillon

L’échantillon de cette recherche est le même pour les deux outils utilisés, à savoir le SRLIS et le SELF. J’ai constitué l’échantillon par convenance et relations amicales ; le seul critère retenu était d’être un-e étudiant-e universitaire. J’ai ensuite expliqué le cadre de la recherche et les contraintes des outils. Parmi eux, j’ai sélectionné deux étudiant-e-s universitaires, avec lesquelles j’ai fixé une date pour la passation de l’entretien et du questionnaire.

Le premier sujet, que j’appelle sujet A, est une étudiante universitaire femme de 22 ans. Elle fréquente l’Ecole polytechnique fédérale de Lausanne (EPFL) et est couramment au premier semestre de Master. Elle est inscrite dans un programme en branche principale en « Biological and chemical process in environmental engineering » et en branche secondaire en « Biotechnology ». Le deuxième sujet, que j’appelle sujet D, est une étudiante femme universitaire de 25 ans. Elle fréquente l’université de Fribourg et est couramment à la troisième année de Bachelor. Elle est inscrite dans un programme en branche principale en Langue et littérature anglaise et en branche secondaire en Sciences de la communication.

Description de la méthodologie

En s’agissant d’un entretien semi-directif, dans un premier moment, j’ai vérifié les traductions pour les scénarios et complété la guide d’entretien avec la question de relance, celle sur la régularité des stratégies et les éléments démographiques à demander aux sujets, à savoir le nom, l’âge, la voie et le niveau d’études, et les informations importantes à donner, comme le cadre de la recherche et les droits du / de la répondant-e. L’entretien dure environ 25 minutes et les réponses sont anonymes et traitées de manière confidentielle. Avec le sujet A, l’entretien s’est passé à distance, dans un contexte isolé. Avec le sujet D, l’entretien s’est passé en présentiel dans un contexte informel, mais isolé.

J’ai commencé en donnant une explication du cadre de la recherche, des objectifs du test et du travail à rédiger, en demandant son consensus pour l’enregistrement. Après l’entretien, j’ai procédé à la transcription des entretiens à l’aide d’un outil en ligne. Avec une copie écrite des transcriptions, j’ai pu commencer avec le codage dans deux tableaux de chaque stratégie mentionnée selon les 15 catégories ci-dessus mentionnées. Le premier tableau récolte les stratégies mentionnées dans chacun des scénarios, avec des extraits et leur régularité, mesurée sur une échelle de 1 à 4 (1 = rarement ; 2 = occasionnellement ; 3 = fréquemment ; 4 = la plupart du temps). Le deuxième compte les apparitions au niveau de leur fréquence totale sur l’ensemble des scénarios. Pour interpréter les données, j’ai choisi de me concentrer sur les stratégies les plus utilisées, leur fréquence d’apparition totale, et les éléments les plus intéressants ressortis de l’entretien.

Présentation des résultats

En regardant les deux sujets ensemble, il y a six stratégies qui ont été mentionnées par les deux. Il s’agit de l’autoévaluation, l’organisation et la transformation, la fixation des objectifs et planification, la recherche d’informations, la tenue de registres et suivi, et la répétition et mémorisation. Ensuite, il y a cinq stratégies qui n’ont jamais été mentionnées. Ce sont la recherche d’aide sociale par les pairs, enseignant-e-s ou parents et l’examen des notes et manuels. La stratégie la plus souvent mentionnée au travers des deux entretiens est l’organisation et transformation, avec une fréquence de onze apparitions. Après, avec des fréquences de sept apparitions chacune, l’autoévaluation, la fixation d’objectifs et planification et la recherche d’informations. Enfin, avec une fréquence de six apparitions totales, la répétition et mémorisation. Les stratégies les moins mentionnées sont la structuration de l’environnement avec trois apparitions, puis les conséquences personnelles, l’examen des notes et une stratégie classée comme « Autre » avec une apparition chacune.

Pour le sujet A, la stratégie la plus fréquemment nommée est l’organisation et la transformation, avec six apparitions totales, suivie par la fixation des objectifs et planification et la répétition et mémorisation, avec quatre apparitions totales. Par la fréquence d’apparition mineure (une apparition totale) on trouve l’examen des notes et une stratégie classée comme « Autre ». En général, le sujet A semble plus consciente des comportements et des stratégies utilisées dans les diverses parties de son apprentissage, et les réponses autour de la régularité reflètent très bien leur fréquence d’apparition. J’ai trouvé intéressant comment elle souligne souvent la dépendance entre la stratégie utilisée et les contraintes du contexte, comme la disponibilité des indications explicites du professeur ou la proximité du délai, qui va augmenter le niveau du stress qu’elle perçoit comme forte motivation. La stratégie la plus fréquemment mentionnée, à savoir l’organisation et la transformation, consiste dans la réorganisation du matériel pédagogique pour faciliter son propre apprentissage. Le sujet A mentionne la stratégie six fois en exprimant sa préférence pour des notes écrites « de façon propre, bien à étudier », parce qu’elle arrive à travailler mieux (et à s’en souvenir) sur ses propres résumés. En plus, elle explique comment, dans le cas où un travail écrit est demandé, elle cherche à se baser sur la table de matière donnée par le professeur pour commencer « déjà à créer mon squelette de documents s’entourés des chapitres », ce qui l’aide à ne « pas oublier des parties importantes ». Pour le sujet A il s’agit d’une stratégie très utilisée, identifiée dans quatre scénarios sur six, avec une régularité entre « fréquemment » et « la plupart du temps ». L’examen des notes a été identifié chez le sujet A dans le scénario autour de la préparation aux examens, avec une régularité haute (« plupart des temps ») ; la stratégie « Autre » a été identifiée dans le scénario autour de la motivation, avec une régularité aussi haute. En effet, elle a souligné qu’elle n’utilise aucune stratégie de manière aussi régulière, car le stress est souvent la principale source de motivation.

Pour le sujet D aussi, la stratégie la plus fréquemment nommée est l’organisation et la transformation, avec cinq apparitions totales, suivie par l’autoévaluation et la recherche d’informations avec quatre apparitions totales. Avec la fréquence d’apparition mineure (une apparition totale), on trouve la tenue de registres et suivi et les conséquences personnelles. La variété des modalités de révision ou de travail mentionnées est plus faible que chez l’autre sujet (ici, le sujet utilise très souvent les résumés du matériel pédagogique), mais les stratégies mises en pratique dans la création des résumés sont plusieurs. Parfois, il y a une moindre prise de conscience de ses propres stratégies, mais la régularité exprimée reflète bien la fréquence d’apparition des stratégies. La stratégie de l’organisation et de la transformation du matériel pédagogique est mentionnée cinq fois au travers de la moitié des scénarios proposés. Elle explique en fait qu’elle construit « beaucoup de résumés ou comme ça, des mappes mentales, […] des schémas avec toutes les flèches pour les interactions, les corrélations ». Pour le sujet D, c’est aussi une stratégie à laquelle elle recourt fréquemment, avec une régularité évaluée comme « fréquemment ». Des stratégies les moins mentionnées, la tenue de registres et suivi et les conséquences personnelles ont été retrouvées chez le sujet D dans les scénarios autour de la motivation et du travail en dehors du cours, avec une régularité faible (entre « rarement » et « occasionnellement »). La régularité faible est en ligne avec les quelques mentions totales.

Discussion sur l’outil de mesure

Pour discuter et évaluer l’outil SRLIS, je me base sur les concepts de validité et de fidélité. La validité « se réfère au degré auquel les preuves et la théorie soutiennent l’interprétation des scores à un test pour les objectifs proposés du test » (Bandalos, 2018, p.255). Le SRLIS est un outil déjà testé par d’autres chercheurs, mais dans un public différent du mien, ce qui pourrait avoir amené des biais. Au niveau du contenu de l’outil, les quatorze stratégies sont assez claires et extensives, mais dans les entretiens, il arrivait souvent qu’une stratégie mentionnée pouvait se rapprocher de deux catégories. Ceci peut être expliqué par le fait que les modalités d’autorégulation de l’apprentissage présentées par les sujets étaient en fait un mélange de plusieurs stratégies. Par exemple, le sujet A dit qu’elle rédige un texte sur la base d’un index du professeur et des critères d’évaluation, en créant un squelette du produit final lorsqu’elle est encore fraîche de l’argument. Cette déclaration pouvait être considérée comme l’organisation du matériel autant que la planification du travail. Ce conflit dans la validité de l’outil amène à un poids de l’interprétation du chercheur majeur. En plus, à plusieurs reprises les sujets ont exprimé une inadaptation de leur parcours universitaires aux scénarios proposés : « Mais ça ne passe pas trop souvent que je dois rendre des trucs individuels » (sujet A), ce qui a rendu plus difficile leur identification à la situation et élaboration de stratégies mobilisables. L’échelle pour évaluer la régularité posait aussi des problèmes, car les sujets ont souvent hésité à s’autoévaluer, en proposant des scores moyens : « Je peux mettre deux et demi, mais je ne pense pas que c’est possible » (sujet D). En tout cas, les items ont bien ciblé les processus cognitifs visés et ont produit des réponses en ligne avec les relations attendues. Par exemple, la régularité demandée d’une stratégie était assez cohérente avec les fréquences d’apparition dans le scénario.

La fidélité est définie comme le « degré auquel les scores à un test sont fiables ou dignes de confiance, dans le sens que nous obtiendrions des résultats très similaires si nous devions répéter le test » (Bandalos, 2018, p.155). Dans le cas du SRLIS, c’est en fait le même test à être mené dans les temps, mais il est important de souligner que dans cette recherche, il s’agit d’une version traduite et adaptée au contexte universitaire. Néanmoins, la forme utilisée dans ce travail n’a pas été changée.

Self-Efficacy for Learning Form – SELF

Description de l’outil

Le deuxième outil de cette recherche est le questionnaire du Self-Efficacy for Learning Form (SELF), ou Formulaire d’auto-efficacité d’apprentissage. Cette dernière est définie comme les « croyances relatives à la capacité d’une personne d’apprendre ou d’agir efficacement » (Zimmerman & Kitsantas, 2007, p.157). L’outil est censé évaluer le sentiment d’efficacité personnelle perçu par les étudiant-e-s au travers d’un questionnaire de 57 items. Ceux-ci portent sur cinq dimensions : la lecture, la révision, la préparation à un examen, la prise de notes et l’écriture (Zimmerman & Kitsantas, 2005). Les sujets répondent aux questions en évaluant leur sentiment d’auto-efficacité perçu à faire les éléments décrits dans les questions sur une échelle de 0% (certainement pas) à 100% (certainement). La particularité de cet outil est le fait qu’il opérationnalise l’auto-efficacité de manière différente, en mesurant le sentiment d’efficacité personnelle perçue en tant que ce qu’ils-elles peuvent faire, et non ce qu’ils-elles feront ou font habituellement, comme dans le SRLIS.

Description de la méthodologie

Le questionnaire a été passé sur papier et en ligne, mais toujours en présence. La durée était entre 15 et 20 minutes et les sujets avaient le droit de refuser de répondre et de poser des questions de compréhension. Comme dans l’entretien, les données ont été anonymisées et traitées en confidentialité. Les 57 items ont été présentés en ordre mixte, en mélangeant les différentes dimensions dans le but de maintenir l’attention des participantes. Dans le cadre d’un accord inter-juge, les traductions de l’anglais ont été contrôlées et corrigées. Pour chaque question, les sujets devaient entourer le pourcentage qui correspondait à l’évaluation de leur sentiment d’auto-efficacité.

Présentation des résultats

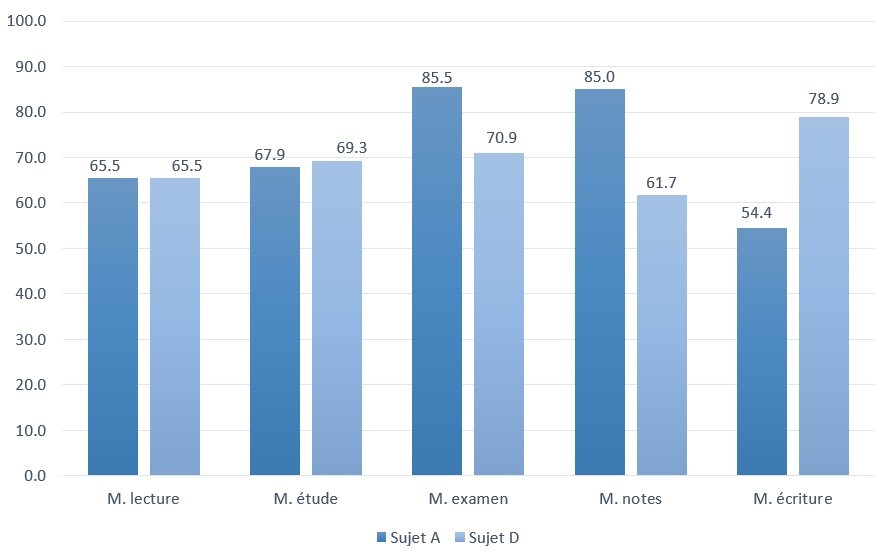

Comme la Figure 1 la montre, les deux sujets présentent des sentiments d’auto-efficacité d’apprentissage moyens assez proches, à savoir 71.6% pour le sujet A et 69.2% pour le sujet D. Dans les dimensions ciblées sur la lecture et la révision, les sujets ont obtenu des scores comparables, tant que dans les autres elles diffèrent davantage. Le sujet A évalue son sentiment d’auto-efficacité comme le plus fort dans la dimension de la préparation aux examens (85.5%) et celle de la prise de notes (85%) et le plus faible dans l’écriture (54.4%). Ses moyennes sont variées selon la dimension mesurée, mais toujours au-dessus de 50%. Le sujet D évalue son sentiment d’auto-efficacité comme le plus fort en écriture (78.9%) et le plus faible dans la dimension de la prise de notes (61.7%). Pourtant, entre les moyennes des dimensions mesurées, il y a moins de variation. Une explication possible de la différence dans les variations du pourcentage entre les dimensions pourrait être le fait que le sujet A était plus favorable à s’autoévaluer sur les extrêmes (0% et 100%), lorsque le sujet D restait plutôt entre 40% et 80%.

Figure 1

Moyenne (en %) des résultats des items du questionnaire SELF par dimension et par sujet

J’ai trouvé intéressant de me focaliser surtout sur les autoévaluations plus faibles, par exemple dans l’écriture pour le sujet A, laquelle est aussi le score le plus bas entre l’ensemble. Elle s’évalue de manière assez variée selon les items, en allant du 100% dans la capacité de trouver des informations sur un sujet inconnu au 0% dans la capacité de se motiver à écrire un texte lorsqu’elle est fatiguée, ou encore 20% dans la capacité à trouver une personne qui puisse aider à corriger les erreurs. Les évaluations plus faibles semblent en fait être liées plus à la motivation à travailler dans un certain temps ou dans certaines conditions et à la recherche de l’aide sociale, plutôt qu’au processus de l’écriture elle-même. Chez le sujet D aussi, les scores plus faibles ressortent dans des items autour de la motivation à commencer une tâche, de la demande d’aide aux enseignant-e-s ou aux pairs, ou encore de la concentration et de la stimulation dans une tâche peu intéressante.

Discussion sur l’outil de mesure

Au niveau du contenu de l’outil SELF, les items dans la même dimension ont produit chez les sujets des autoévaluations à la fois différentes, ce qui a posé un questionnement autour de la validité et de la cohérence interne du test. Une possible explication pourrait être retrouvée dans le fait que les scénarios ne sont pas adaptés aux contextes académiques spécifiques de chaque sujet, qui ont la peine à s’imaginer dans les situations d’apprentissage auto-régulé décrites. Pour ce qui concerne les conséquences du testing, j’ai remarqué une forte influence de ma propre interprétation des résultats. Vu qu’il s’agissait d’un questionnaire passé en présence, les sujets ont fait plusieurs remarques orales sur les items. Ceux-ci offraient des informations en plus, mais qui ne pouvaient pas être prises en considération pour l’interprétation finale, ce qui était dommage.

Comparaison entre SRLIS et SELF

J’ai trouvé plusieurs éléments communs, mais aussi des points divergents entre les résultats des deux outils. Pour les points communs, j’ai trouvé une cohérence entre les stratégies dites mobilisées dans les situations d’apprentissage autorégulé et l’évaluation de l’auto-efficacité d’apprentissage. Le sujet A indique l’organisation et transformation du matériel comme stratégie la plus utilisée et s’évalue comme très capable dans la dimension de la préparation aux examens. Cette dimension présente en fait plusieurs items liés à l’organisation ou transformation du matériel, comme le fait de créer des exemples concrets ou d’associer les informations entre eux. Similairement, le sujet D mentionne la tenue de registres et du suivi et la recherche d’aide sociale comme stratégies les moins mobilisées et s’évalue comme pire dans la prise de notes, qui contient plusieurs items sur la manière d’écrire ou de compléter ses notes et aussi sur la recherche d’aide. Du côté des divergences, j’ai noté que les deux sujets ne semblent pas utiliser souvent la tenue de registres, mais ont à la fois un score élevé dans l’auto-efficacité dans la dimension de prise de notes (sujet A) et des évaluations élevées pour des items y liés dans les dimensions de lecture et prise de notes. Ces différences renforcent l’idée que sa propre capacité à faire quelque chose dans une dimension spécifique d’apprentissage autorégulé dépend en tout temps du contexte et de l’activité spécifique requise.

Conclusions

Même si j’ai utilisé deux outils visant à mesurer des concepts en soi différents, j’ai pu trouver des éléments en commun qui ont permis de lier les stratégies d’apprentissage autorégulé que les sujets pensent utiliser avec leur évaluation du sentiment d’auto-efficacité d’apprentissage. J’ai remarqué en fait que, souvent, l’utilisation fréquente d’une stratégie peut signifier aussi un sentiment d’auto-efficacité élevée, mais que cette relation dépend aussi des circonstances. Par exemple, les items du questionnaire SELF qui portaient sur la motivation, l’engagement et l’aide sociale ont souvent été évalués comme moins forts, même si présentés dans des dimensions fortement liées aux stratégies les plus mobilisées.

J’ai cherché à m’appuyer sur des recherches similaires pour discuter de la validité et fidélité des outils, mais il est important de souligner qu’il y a une grande différence avec cette recherche. L’étude de Zimmerman & Kitsantas (2007), par exemple, a tenté de prédire les résultats des étudiant-e-s à l’aide du SELF, tant que dans ma recherche, il s’agissait de mesurer l’auto-efficacité perçue dans le but d’explorer le concept de l’autorégulation d’apprentissage des étudiant-e-s universitaires. Il aurait aussi été intéressant d’analyser des éventuelles variances selon le genre des participant-e-s, même si les chercheurs n’avaient pas trouvé de différences significatives.

Pour aller plus loin, il serait important d’accorder de l’importance aux contextes d’étude des participant-e-s concernant la faculté d’étude ainsi que sa structure (type d’examens, travaux, matériel …), afin de tenter d’expliquer les résultats et les variances possibles. Pour faire ça, il y aurait besoin surtout d’un échantillon élargi et d’un accord inter-juge plus structuré pour vérifier la fidélité des résultats obtenus. Une dernière piste d’approfondissement serait enfin de structurer la recherche de manière longitudinale, de façon à faire passer les outils aux sujets à diverses étapes de leur parcours universitaire. Le but final sera donc de recueillir et d’évaluer les changements de mobilisation de stratégies et du sentiment d’auto-efficacité entre le début et la fin du Bachelor, ou encore entre Bachelor et Master.

Bibliographie

AERA, APA, & NCME. (2014). The Standards for Educational and Psychological Testing: National Council on Measurement in Education. American Educational Research Association.

Bandalos, D. L. (2018). Measurement theory and applications for the social sciences. The Guilford Press.

Boekaerts, M. (1997). Self-regulated learning: A new concept embraced by researchers, policy makers, educators, teachers, and students. Learning and Instruction, 7(2), 161‑186. https://doi.org/10.1016/S0959-4752(96)00015-1

Dinsmore, D. (2018). Strategic Processing in Education.

Schunk, D. H., & Greene, J. A. (2018). Historical, contemporary, and future perspectives on self-regulated learning and performance. In Handbook of self-regulation of learning and performance, 2nd ed (p. 1‑15). Routledge/Taylor & Francis Group. https://doi.org/10.4324/9781315697048-1

Thompson, B. (2003). Score reliability: Contemporary thinking on reliability issues. Sage.

Winne, P. H., & Perry, N. E. (2000). Measuring self-regulated learning. In Handbook of self-regulation (p. 531‑566). Academic Press. https://doi.org/10.1016/B978-012109890-2/50045-7

Zimmerman, B., & Kitsantas, A. (2005). Homework practices and academic achievement : The mediating role of self-efficacy and perceived responsibility beliefs. Contemporary Educational Psychology, 30(4), 397‑417. https://doi.org/10.1016/j.cedpsych.2005.05.003

Zimmerman, B., & Kitsantas, A. (2007). Reliability and Validity of Self-Efficacy for Learning Form (SELF) Scores of College Students. Zeitschrift für Psychologie / Journal of Psychology, 215(3), 157‑163. https://doi.org/10.1027/0044-3409.215.3.157

Zimmerman, B., & Martinez-Pons, M. (1986). Development of a Structured Interview for Assessing Student Use of Self-Regulated Learning Strategies. American Educational Research Journal, 23, 614‑628. https://doi.org/10.3102/00028312023004614

Zimmerman, B., & Martinez-Pons, M. (1988). Construct validation of a strategy model of student self-regulated learning. Journal of Educational Psychology, 80(3), 284‑290. https://doi.org/10.1037/0022-0663.80.3.284