Auteure : Charline Kapeller

Introduction

Ce travail s’intéresse à l’apprentissage autorégulé et à la métacognition en s’appuyant sur des outils pour les évaluer. Nous en avons utilisé deux, le « Self-Regulated Learning Interview Schedule » (SRLIS) et le « Metacognitive Awareness Inventory » (MAI). Les deux outils seront décrits au niveau de la méthodologie, et des résultats dans le travail. Nous allons aussi les comparer pour essayer de savoir s’ils sont complémentaires sur ce qu’ils évaluent ou s’il est difficile de les comparer. Les deux tests ont été passé par deux étudiant·e·s du niveau tertiaire. Avant de se pencher plus en détails sur les tests, il nous semble important de revenir sur les définitions de l’autorégulation et de la métacognition.

L’autorégulation est un facteur qui peut prédire la réussite plus ou moins grande des élèves. Selon Zimmerman (2002), l’autorégulation est « cyclique » et met en relation trois processus : « les processus personnels, comportementaux et environnementaux » (p.71). Ces processus sont eux-mêmes diviser en plusieurs stratégies qui permettent d’accomplir des objectifs. Zimmerman (2002) cite plusieurs de ces stratégies, « comme le monitoring, la gestion du temps, la fixation d’objectifs, l’auto-évaluation, la recherche d’aide ou l’ajustement des conditions de contexte de l’apprentissage » (pp. 71-73).

La métacognition rentre aussi en jeu durant les apprentissages, car elle est un facteur de l’apprentissage autorégulé. Elle permet « de réfléchir sur son apprentissage, de le comprendre et de le contrôler » (Schraw et Dennison, 1994, p. 460). Elle est divisée en trois composantes : « les connaissances métacognitives, les expériences métacognitives et les stratégies métacognitives » (Berger et Büchel, 2012, p.96). Ces trois composantes contiennent elles-mêmes d’autres composantes comme « les connaissances des apprenant·e·s, les sentiment et jugements subjectifs relatifs à l’entreprise cognitive et les décisions prises sur la base des expériences ». (Berger et Büchel, 20122, p.96).

1. Une partie sur le SRLIS

1.1 Description de l’outil

Il existe différents moyens d’évaluer l’autorégulation des élèves, l’outil « Self-Regulated Learning Interview Schedule » (SRLIS) en est un. Il est composé de six scénarios qui permettent de questionner des étudiant·e·s sur leurs stratégies d’autorégulation (Zimmerman et Pons, 1986). Cet outil sous forme d’interview permet « d’évaluer 14 stratégies » (Zimmerman et Pons, 1990, p.52). Une quinzième a été rajouté pour classer des stratégies qui ne rentrent pas dans les autres catégories (Zimmerman et Pons, 1990). Pour augmenter la validité du test, une deuxième partie a été ajoutée. Il s’agit des observations des enseignant·e·s par rapport aux stratégies que les élève utilisent en classe (Zimmerman et Pons, 1988). Pour analyser les données, il faut commencer par décortiquer les réponses des élèves et y déceler des stratégies. Une fois les stratégies décelées, il faut les classer selon leur nature parmi les 14 prises en compte. Ce classement est effectué de manière dichotomique (Zimmerman et Pons, 1986). Une fois ce classement effectué, il faut encore mesurer le « nombre de fois que la stratégie a été mentionnée » (Zimmerman et Pons, 1986, p. 620). Une fois toutes ces données récoltées, il faut effectuer une « analyse discriminante » pour en tirer des conclusion (Zimmerman et Pons, 1986, p. 621).

1.2 Description de l’échantillon

Nous avons constitué un échantillon de convenance qui se compose d’une étudiante de 26 ans et d’un étudiant de 24 ans. Les deux sont actuellement dans un cursus Bachelor à l’université de Fribourg. L’étudiante fait des études en chimie dans la faculté des sciences et de la médecine. Elle a d’abord fait un apprentissage de laborantine en chimie. L’étudiant étudie l’histoire et l’anglais dans la faculté des lettres et des sciences humaines. L’anglais est sa branche complémentaire à 60 crédits, qu’il a commencé ce semestre après avoir reçu un échec définitif en économie. Les deux personnes qui ont participé à l’interview ont des chemins différents ce qui peut expliquer des différences dans les résultats.

1.3 Description de la méthodologie

Pour les interviews, nous avons choisi la traduction en français déjà existante et les scénarios modifiés pour concorder avec notre public cible d’étudiant·e·s de niveau tertiaire. Nous avons procédé à un entretien directif en commençant par expliquer les tenants et aboutissants de cet exercice. Les étudiant·e·s ont été informé·e·s que l’entretien serait enregistré, anonyme et que les résutlats seront utilisés dans le cadre d’un cours qui porte sur l’autorégulation des apprentissages. Après avoir reçu leur accord, nous avons fixé une date différente pour les deux afin de réaliser l’interview, Nous avons choisi un endroit calme pour ne pas être dérangé·e·s.

Le jour de l’entretien, nous avons commencé par collecter certaines données comme l’âge, le niveau d’étude et la faculté. Nous leur avons demandé de lire une première fois les six scénarios avant de commencer à répondre. En même temps qu’ils·elles mettaient en avant des stratégies, nous leur demandions de nous dire la régularité d’utilisation de celles-ci sur une échelle de Likert entre 1 et 4 (1 = rarement, 2 = occasionnellement, 3 = fréquemment, 4 = la plupart du temps). Les deux interviews ont duré une quintaine de minutes. Nous avons dû pour certains scénarios passer plus de temps pour bien comprendre les stratégies qui étaient mises en place par l’étudiante et l’étudiant.

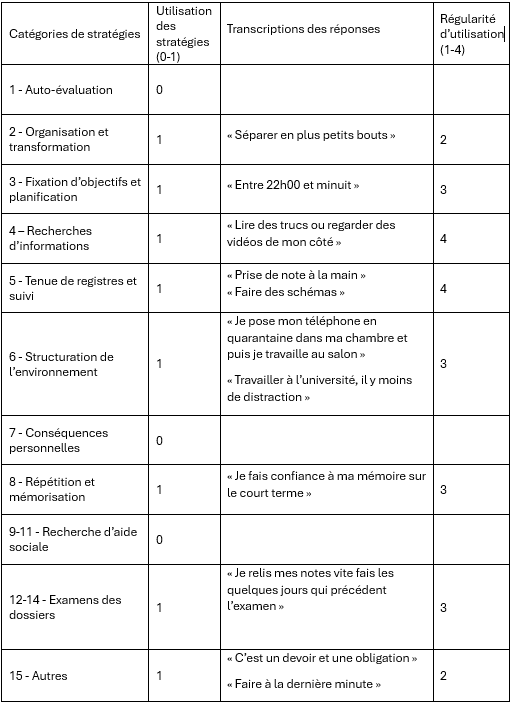

Après les interviews, nous avons pris le temps de les retranscrire pour avoir une trace écrite et de pouvoir les analyser au mieux (c.f. Annexe 1 et 2). À la suite de la retranscription, nous avons construit deux tableaux, un pour chaque étudiant·e. Ils permettent de mettre en avant les stratégies utilisées selon les catégories du SRLIS, les verbatims et la régularité d’utilisation.

1.4 Présentation des résultats

L’utilisation de tableau permet une meilleure lecture des résutlats, ainsi que des différences ou des similitudes entre les deux étudiant·e·s.

Tableau 1

Analyse des réponses de l’étudiant

Nous pouvons constater que 4 stratégies ne sont pas utilisées par cet étudiant. Il s’agit de l’auto-évaluation, de la structuration de l’environnement, des conséquences personnelles et de la répétition et mémorisation. Cette personne accorde de l’importance à la planification et à l’organisation de son travail. Étant sujet à l’anxiété, cette personne a besoin d’organiser ses devoirs et ses travaux pour savoir quand débuter et étaler le travail sur plusieurs semaines. Il a mis en évidence sa prise de note à la main, ce qui a pu nous surprendre car une grande majorité des étudiant·e·s ont un ordinateur pour prendre leurs notes de cours. Pour certains, scénarios avant de répondre plus précisément, il répondait qu’il faisait ce qu’il lui était demandé. C’est en lui posant des questions plus précises qu’il a pu nous décrire ses stratégies. Il recherche aussi de la documentation en plus pour aller plus loin dans sa compréhension des sujets abordés en classe.

Tableau 2

Analyse des réponses de l’étudiante

Nous pouvons constater que pour cette étudiante 3 stratégies n’ont pas été mentionnées, celle de l’auto-évaluation, celle des conséquences personnelles et celle de la recherche d’aide sociale. Cette étudiante a besoin de structurer son environnement avant d’étudier, cela lui permet de mieux se concentrer et de moins procrastiner. Elle prend aussi ses notes à la main car elle n’aime pas les prendre à l’ordinateur. Son choix d’étude joue un rôle aussi dans la prise de note à la main. Elle étudie la chimie et rencontre donc beaucoup de schémas et de calculs. Il est plus facile de les noter à la main que sur ordinateur. Elle mentionne aussi des stratégies qui se classent dans la catégorie « autre ». Ces stratégies sont plus de l’ordre de la procrastination et de devoir tout faire à la dernière minute sans réel plan ou organisation. Elle sépare aussi en deux les devoirs, ceux qui ne suscitent pas beaucoup d’intérêt pour elle et qu’elle ne voit que comme une obligation et ceux qui la motive et qu’elle a plaisir à faire. Elle va chercher des informations supplémentaires pour les sujets qui la motivent. Il ressort de ces résultats une difficulté à s’autoréguler et à planifier. Elle a mentionné plusieurs fois le fait qu’elle procrastinait et qu’elle faisait les choses à la dernière minute.

Nous pouvons constater des similitudes et des différences entre ces deux étudiant·e·s. Pour ce qui est des similitudes, les deux personnes prennent des notes à la main mais pas pour les mêmes raisons. L’étudiant prend des notes à la main pour raison d’efficacité de mémorisation des cours, tandis que pour l’étudiante, c’est plutôt la branche qu’elle étudie qui se prête mieux à une prise de note à la main. Tou·te·s les deux vont chercher des ressources supplémentaires après les cours pour avoir plus d’informations sur le sujet. Les deux ont des stratégies qui se classent dans la catégorie « autre ».

Une différence flagrante entre les deux se trouve dans la planification. L’étudiant planifie et organise son travail pour le commencer au plus vite, tandis que l’étudiante fait tout à la dernière minute et même lorsqu’elle essaie de planifier, elle ressent du stress. La révision des examens est une différence entre les deux. Ils·elles relisent leur note mais pour une c’est quelques jours avant l’examen et pour l’autre, il en rajoute ou refait des exercices toujours bien avant l’échéance.

Pour ce qui est des répétitions, nous pouvons constater qu’il y a des différences entre ce qu’ils pensent utiliser et ce qu’ils ont répondu dans l’interview. Une hypothèse sur cette différence pourrait venir des scénarios qui se concentrent sur une situation, alors que les étudiant·e·s pensent plus en général, pour tous les cours.

1.5 Discussion sur l’outil de mesure

Il est difficile de juger un tel outil de mesure en ayant interviewé que deux personnes. Néanmoins ce qu’il en est ressorti en discutant avec eux, c’est que tous les scénarios se ressemblaient et qu’ils n’étaient pas forcément adaptés au contexte tertiaire. Les étudiant·e·s ont eu du mal à se reconnaître dans les scénarios car ils ne correspondent pas forcément aux travaux qu’ils·elles rencontrent durant leur étude. Ce manque de correspondance pourrait diminuer la validité du test.

Nous avons rencontré quelques difficultés à classer certaines stratégies dans les catégories établies par Zimmerman et Pons. Cette difficulté peut être atténuée en utilisant un accord inter-juge (Zimmerman et Pons, 1986).

Cependant cet interview a permis, en tout cas, pour l’étudiante de se rendre compte des certains défauts ou mauvaises manies qu’elle a lorsqu’elle doit réviser ou travailler pour les cours.

2. Une partie sur MAI

2.1 Description de l’outil

L’outil « Metacognitive Awareness Inventory » (MAI) est un questionnaire quantitatif qui permet de mesure la conscience métacognitive des apprenant·e·s en mettant l’accent sur la connaissance de la cognition et la régulation de cette dernière (Schraw et Dennison, 1994). L’outil de mesure comporte 52 items qui sont classés en deux grandes catégories qui elles-mêmes contiennent des sous-catégories. La première grande catégorie, connaissance de la cognition, contient trois sous-catégories, « les connaissances déclaratives, procédurales et conditionnelles » (Schraw et Dennison, 1994, p. 460). La deuxième grande catégorie, régulation de la cognition, contient cinq sous-catégories ; « la planification, les stratégies de gestion de l’information, le monitoring, les stratégies de debbuging et l’évaluation » (Schraw et Dennison, 1994, p 460). Cet outil a été mis sur pied pour évaluer la métacognition des adolescents et des adultes. Pour rappel, « la métacognition se réfère à la capacité de réfléchir sur son apprentissage, de le comprendre et de le contrôler » (Schraw et Dennison, 1994, p. 460). La première échelle utilisée pour répondre à ce questionnaire était une échelle visuelle sous forme de ligne de faux à vrai. La ligne mesurait « 100mm et les participant·e·s devaient noter d’une barre oblique où ils·elles se situaient entre le faux et le vrai » (Harrison et Vallin, 2018, p.17). Le score était calculé en millimètre, le questionnaire se faisait sur papier. Actuellement, la façon de répondre a un peu changé et nous pouvons trouver des questionnaires MAI avec une échelle de Likert. Cette échelle permet de répondre plus facilement au questionnaire sans remettre en cause sa valeur.

2.2 Description de la méthodologie

L’échantillon est le même que pour l’outil précédent (SRLIS). Il s’agit d’une étudiante et d’un étudiant de l’université de Fribourg. Nous avons utilisé Google Forms pour faire passer le questionnaire aux étudiants. Cette méthode nous paraissait la plus simple pour avoir toutes les données au même endroit et travailler dessus. Le questionnaire a été envoyé aux étudiant·e·s par message et ils·elles y ont répondu au moyen d’une échelle de Likert allant de 1 à 10. Ils·elles ont pu le faire au moment qu’il leur convenait le mieux. Ils·elles devaient obligatoirement répondre aux 52 items qui ont été randomisés pour éviter un biais lié à l’ordre des questions. Le questionnaire a duré une dizaine de minutes pour nos deux étudiant·e·s car certains items étaient plus difficiles à comprendre.

Pour analyser les réponses des étudiant·e·s, nous avons créé deux tableaux en faisant les moyennes des items. Le premier tableau met en avant les moyennes pour les deux grandes catégories qui sont la connaissance de la cognition et la régulation de la cognition. Le deuxième tableau met en avant les huit sous-catégories qui composent les deux grandes. Nous avons mis ces tableaux sous forme de graphique pour que la lecture des résultats soit simplifiée.

2.3 Présentation des résultats

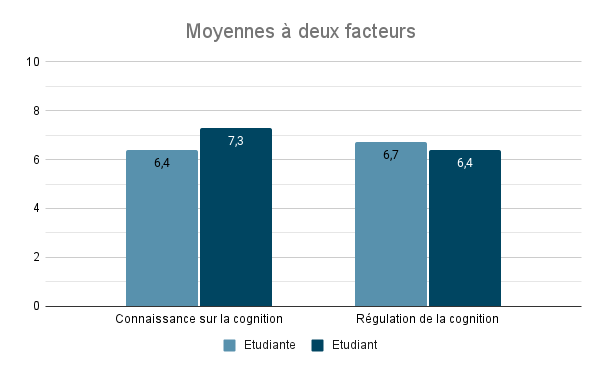

Graphique 1

Résultats à deux facteurs

Ce premier graphique contient les résutlats pour la connaissance sur la cognition et sur la régulation de celle-ci, cela signifie que les huit processus ne ressortent pas individuellement dans ces graphiques mais sont intégrés dans des catégories plus larges.

Nous pouvons observer pour l’étudiante des scores relativement proches pour les deux catégories. Elle a une connaissance sur la cognition un peu plus haute que la moyenne ainsi que la régulation de la cognition.

Ce n’est pas le cas pour l’étudiant qui a une différence de presque 1 point entre la connaissance et la régulation de la cognition. Nous pouvons faire l’hypothèse qu’il connaît les façons qui fonctionne le mieux mais qu’il n’arrive pas forcément à les mettre en pratique.

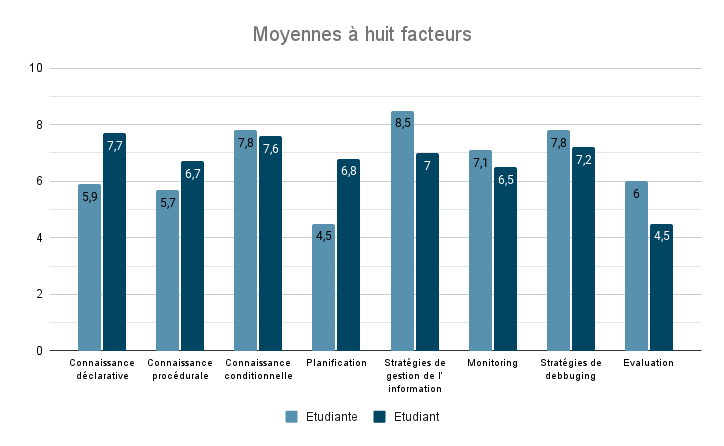

Graphique 2

Résutlats à huit facteurs

Ce graphique montre en détail les résultats des huit sous-catégories. Il permet de mieux comprendre d’où sortent les résutlats du premier graphique.

Nous pouvons observer pour l’étudiante des résultats plutôt haut pour les catégories connaissances conditionnelles, stratégies de gestion de l’information, monitoring et stratégies de debbuging. Cela indique qu’elle sait utiliser des stratégies pour résoudre des problèmes ou pour gérer les informations. L’évaluation, la connaissance déclarative et la connaissance procédurale sont plus ou moins au même niveau avec un résultat proche de 6. En revanche pour ce qui est de la planification, l’étudiante obtient un score de 4,5. Nous pouvons faire l’hypothèse que ce qui lui pose le plus de problème dans ses études.

Pour l’étudiant, nous pouvons observer des scores assez haut pour les trois catégories qui portent sur les connaissances, ce qui confirme le score que nous avions pour la moyenne de la connaissance sur la cognition. Pour la planification, les stratégies de gestion de l’information, le monitoring et les stratégies de debbuging, l’étudiant a des scores entre 6,5 et 7,2. Avec ces résutlats, nous pouvons faire l’hypothèse qu’il sait se servir de stratégies pour résoudre des problèmes, pour planifier et pour gérer les informations. Néanmoins même si les scores sont bons, nous pouvons voir une différence entre ces quatre résultats et les résutlats des connaissances déclaratives et conditionnelles. Cet étudiant a un score de 4,5 pour la catégorie évaluation. Nous pouvons faire comme hypothèse qu’il n’utilise pas énormément l’évaluation dans ses apprentissages.

2.4 Discussion sur l’outil de mesure

La passation du questionnaire est facile et permet aux participant·e·s de répondre au moment le plus opportun pour eux·elles. Le questionnaire ne dure qu’une dizaine de minutes, ce qui permet aux étudiant·e·s de répondre en une seule fois et de ne pas trouver cela trop long. Pour nous, les résultats sont vite là et faciles à travailler car ils sont sous formes de chiffre. Il nous reste à trier les items par catégories et à faire des moyennes. Nous avons eu un retour plutôt positif des étudiant·e·s malgré quelques items plus difficile à comprendre.

L’outil a différents biais qui selon nous pourrait mettre en difficultés son utilisation pour des recherches scientifiques sur la métacognition. Le premier biais que nous voyons, se trouve sur le nombre d’item par catégorie qui varie entre quatre et neuf, ce qui a pour conséquence qu’il n’y ait que 17 items pour la connaissance sur la cognition et 35 items pour la régulation de la cognition. Un deuxième biais concerne la validité de ce test. Les étudiant·e·s répondent à un questionnaire et peuvent sans le vouloir répondre ce qu’ils·elles pensent faire plutôt que ce qu’ils·elles font réellement. Harrison et Vallin (2018), appellent cela « la désirabilité sociale » (p.33). Un troisième biais qui est ressorti, c’est la grande différence de score dans les items qui traitent de la même catégorie. Nous avons remarqué que pour une même catégorie, il pouvait avoir un score de 1 et d’un score de 10. Est-ce que cette différence peut s’expliquer par une mauvaise compréhension des items ou cela est dû à un problème interne aux items ?

Même si nous pensons qu’il est difficile d’utiliser ce test pour une recherche scientifique, nous pensons qu’il peut être utile pour aider les étudiant·e·s à se rendre compte de certaines de leurs difficultés dans la régulation ou la connaissance de la cognition. Ces résutlats pourraient constituer une base qui permettrait de personnaliser les suivis des personnes en se concentrant sur une ou deux catégories de stratégies qui leur posent plus de difficultés.

3. Une comparaison entre les deux outils

La comparaison des deux outils est difficile dans la mesure où ils n’évaluent pas exactement la même chose et par leur différence dans la façon de donner les résutlats. Il n’est pas aisé de comparer des scores chiffrés à des verbatims ou à des utilisations de stratégies. L’entretien évalue plutôt l’apprentissage autorégulé et le questionnaire évalue la métacognition. Le SRLIS permet de connaître ce que font réellement les étudiant·e·s car la passation se fait au travers d’une interview dirigée. Le questionnaire lui peut plus facilement évaluer ce que les étudiant·e·s pensent faire plutôt que ce qu’ils·elles font réellement.

Nous pensons néanmoins que ces deux outils peuvent se compléter. Il serait intéressant de combiner les deux tests afin de mieux se connaître au niveau des stratégies utilisées lors des études universitaires. Les deux outils utilisés ensemble permettent de mettre en lumière des informations cohérentes ou incohérentes. Par exemple pour l’étudiante qui a passé les deux tests, nous a répété plusieurs fois durant l’interview qu’elle avait conscience de n’avoir aucune régulation mais dans le MAI, elle a un score plus élevé que l’étudiant dans la catégorie régulation de la cognition. En général aussi dans les cinq sous-catégories qui forment la catégorie régulation, elle a des scores plus hauts que l’étudiant. Cette différence nous questionne. Est-ce que les scénarios de l’interview sont trop généraux et ne permettent pas une bonne énumération des stratégies ? Est-ce que les items du questionnaire sont n’évaluent pas ce qu’ils devraient évaluer ? Ou est-ce que le biais de désirabilité sociale est fort ? Il faudrait pouvoir discuter avec l’étudiante de ses résutlats pour savoir quelle hypothèse est la plus probable ou si c’est autre chose qui explique cette différence.

Nous pouvons reprocher aux deux outils de ne pas prendre en compte les côtés motivationnels et émotionnels des étudiant·e·s, car ces deux facteurs peuvent aussi expliquer des choses sur la métacognition et l’autorégulation des apprentisssages.

Il faut tenir compte des biais qui peuvent survenir en passant ce genre de test. Les étudiant·e·s peuvent donner des réponses qui ne reflètent qu’une partie de la réalité parce qu’ils·elles ont une mauvaise connaissance d’eux·elles-mêmes ou parce qu’ils·elles veulent donner des réponses plaisantes car ils·elles nous connaissent. Il faudrait utiliser ces outils pour comprendre d’où peuvent venir certains problèmes mais il nous semble difficile de les utiliser pour établir un profil d’apprenant·e.

4. Conclusion

En conclusion, il est difficile d’évaluer et d’analyser des processus internes comme l’apprentissage autorégulé et la métacognition. Il faut tenir compte de plusieurs biais que nous avons vu plus haut, comme la désirabilité sociale, la mauvaise compréhension des items ou encore la capacité qu’ont les étudiant·e·s à réfléchir sur leurs stratégies d’apprentissages. Le SRLIS et le MAI ont des avantages comme des désavantages dans l’évalaution de ces stratégies. Le SRLIS permet d’avoir une réponse directe et claire concernant les stratégies utilisées. Néanmoins, il faudrait ajuster les scénarios pour qu’ils soient plus parlant aux étudiant·e·s du niveau tertiaire. Le MAI permet d’avoir une vision graphique des résutlats chiffrés. Néanmoins, il faudrait réévaluer les items et surtout leur nombre dans les différentes catégories.

Nous pensons que le SRLIS et le MAI sont complémentaires dans une certaine mesure. Une réflexion découle de ce constat. Comment combiner les deux efficacement pour évaluer l’apprentissage autorégulé ? En sachant que les processus d’apprentissage sont personnels et qu’il n’y a pas qu’une seule façon de faire.

Références

- Berger, J.-L. et Büchel, F. P. (2012). Métacognition et croyances motivationnelles : un mariage de raison. Revue française de pédagogie, 179, 95–128. https://doi.org/10.4000/rfp.3705

- Harrison, G. M., & Vallin, L. M. (2018). Evaluating the metacognitive awareness inventory using empirical factor-structure evidence. Metacognition and Learning, 13(1), 15–38. https://doi.org/10.1007/s11409-017-9176-z

- Schraw, G., & Dennison, R. S. (1994). Assessing metacognitive awareness. Contemporary Educational Psychology, 19 (4), 460–475. https://doi.org/10.1006/ceps.1994.1033

- Zimmerman, B. J. (2002) Becoming a Self-Regulated Learner: An Overview, Theory Into Practice, 41:2, 64-70, https://doi.org/10.1207/s15430421tip4102_2

- Zimmerman, B. J., & Martinez-Pons, M. (1988). Construct Validation of a Strategy Model of Student Self-Regulated Learning. Journal of Educational Psychology, 80(3), 284–290. https://doi.org/10.1037/0022-0663.80.3.284

- Zimmerman, B. J., & Martinez-Pons, M. (1990). Student differences in self-regulated learning: Relating grade, sex, and giftedness to self-efficacy and strategy use. Journal of Educational Psychology, 82(1), 51–59. https://doi.org/10.1037/0022-0663.82.1.51

- Zimmerman, B. J., & Pons, M. M. (1986). Development of a structured interview for assessing student use of self-regulated learning strategies. American Educational Research Journal, 23(4), 614–628. https://doi.org/10.2307/1163093