Auteure : Alice Luisoni

1. Introduction

La capacité à autoréguler son apprentissage est un facteur déterminant de la réussite scolaire (Pintrich, 1999). Les apprenant·e·s capables d’autoréguler leurs apprentissages sont ceux et celles qui se fixent des objectifs, tout en surveillant, régulant et contrôlant activement leur cognition, leur motivation et leur comportement (Pintrich, 2000). Parmi les composantes de l’apprentissage autorégulé figure la métacognition, qui désigne la connaissance de ses propres connaissances, processus et états cognitifs et affectifs et la capacité à surveiller et à réguler consciemment ces éléments, permettant ainsi aux apprenant·e·s d’ajuster leur apprentissage aux exigences des tâches (Greene, 2018; Hacker, 1998). Des recherches montrent que les apprenant·e·s ayant de bonnes compétences métacognitives sont plus stratégiques et obtiennent de meilleurs résultats (Young et Fry, 2008).

Étant donné l’importance de l’autorégulation de l’apprentissage et de la métacognition dans la réussite académique, il est important de disposer d’outils permettant de mesurer ces capacités chez les apprenant·e·s.

Ce travail présente l’application de deux outils d’évaluation : le Self-Regulated Learning Interview Schedule (SRLIS) et le Metacognitive Awareness Inventory (MAI). Le SRLIS est une interview structurée conçue pour évaluer l’apprentissage autorégulé des apprenant·e·s. Le MAI est un questionnaire qui permet de mesurer la conscience métacognitive chez les adultes. Ces deux instruments seront décrits et analysés à travers leur mise en pratique sur un échantillon de deux étudiantes de l’Université de Fribourg. Enfin, une comparaison entre les deux méthodes sera effectuée afin de mettre en évidence leurs complémentarités.

1. Self-Regulated Learning Interview Schedule (SRLIS)

Description de l’outil

Le SRLIS, développé par Zimmerman et Martinez-Pons (1986), prend la forme d’un entretien directif et structuré à réponse libre d’une durée d’environ 20 minutes, au cours de laquelle les étudiant·e·s sont invité·e·s à décrire les méthodes qu’ils ou elles utilisent dans 6 scénarios sollicitant l’autorégulation en situation d’apprentissage. En particulier, les réponses permettent d’évaluer l’utilisation de 14 stratégies d’apprentissage autorégulé, qui ont été définies sur la base des recherches antérieures (Zimmerman et Martinez-Pons, 1988).

Description de l’échantillon

L’échantillon se compose de deux étudiantes de l’université de Fribourg, toutes deux âgées de 24 ans et appartenant à la Faculté des Lettres et des Sciences Humaines. La première étudiante est en troisième année de Bachelor en psychologie, tandis que la seconde est en deuxième année de Master en enseignement spécialisé. Les deux participantes, qui font partie de mon entourage, ont exprimé leur intérêt et se sont portées volontaires pour répondre aux questions des deux outils.

Description de la méthodologie

Les interviews ont duré environ 15 minutes chacune et ont été enregistrées. L’interview débutait par une présentation des objectifs et du déroulement de l’étude, qui incluaient des informations sur la confidentialité des réponses, leur anonymisation, et l’utilisation exclusive des données à des fins de recherche scientifique. J’ai ensuite procédé à la collecte de données démographiques de base, à savoir : âge, genre, faculté, niveau d’études.

Les scénarios, adaptés au contexte universitaire[1], ont été présentés aux personnes interviewées qui ont été invitées à indiquer les stratégies utilisées dans ce type de contexte. Quand elles mentionnaient une ou plusieurs stratégies, je leur demandais d’évaluer la régularité avec laquelle chaque stratégie était utilisée selon une échelle visuelle à quatre points (rarement = 1, occasionnellement = 2, fréquemment = 3, et la plupart du temps = 4). L’échelle visuelle a été fournie aux participantes en début d’entretien.

À partir de l’identification des stratégies, trois scores ont été utilisés pour coder les données (Zimmerman et Martinez-Pons, 1986). L’utilisation des stratégies (SU) a été mesurée de manière dichotomique sur une échelle de 0 à 1 et elle permet de nous dire si une stratégie a apparu dans l’un des six scénarios. La fréquence des stratégies (SF) indique le nombre de fois qu’une certaine stratégie a été mentionnée au travers des six contextes. Enfin, la cohérence de la stratégie (CS) évalue la mesure dans laquelle les stratégies déclarées comme étant les plus fréquemment utilisées pour une personne sont appliquées de manière cohérente dans différents contextes. Elle est calculée en fonction de l’évaluation de chaque stratégie, notée par les participantes sur une échelle de 4 points.

Présentation des résultats

| Tableau 1 : Stratégies d’apprentissage autorégulé pour chaque score | ||||||

| Stratégies | P1 | P2 | ||||

| SU | SF | CS | SU | SF | CS | |

| 1. Auto-évaluation | 1 | 1 | 3 (3) | 0 | 0 | |

| 2. Organisation et transformation | 1 | 2 | 4 (8) | 1 | 4 | 4 (16) |

| 3. Fixation d’objectifs et planification | 1 | 4 | 4 (16) | 1 | 2 | 3 (6) |

| 4.Recherche d’informations | 1 | 1 | 3 (3) | 1 | 2 | 3 (6) |

| 5. Tenue de registres et suivi | 1 | 1 | 4 (4) | 1 | 1 | 4 (4) |

| 6. Structuration de l’environnement | 0 | 0 | 1 | 1 | 4 (4) | |

| 7. Conséquences personnelles | 0 | 0 | 1 | 1 | 3 (3) | |

| 8. Répétition et mémorisation | 1 | 1 | 2 (2) | 1 | 1 | 3 (3) |

| 9-11. Recherche d’aide sociale | 0 | 0 | 1 | 1 | 2 (2) | |

| 12-14. Examen des dossiers | 1 | 1 | 4 (4) | 1 | 2 | 3 (6) |

| 15. Autres | 1 | 1 | 1 | 0 | ||

Résultats participante 1 (P1):

La participante 1 mobilise plusieurs stratégies d’autorégulation de l’apprentissage qu’elle adapte en fonction du contexte, en mentionnant 7 stratégies sur 10 dans les six contextes. Les stratégies « Structuration de l’environnement », « Conséquences personnelles » et « Recherche d’aide sociale » n’ont été évoquées dans aucun contexte.

En ce qui concerne la fréquence des stratégies, la stratégie la plus fréquemment citée est « Fixation d’objectifs et planification », présente dans 4 des 6 contextes. La participante a indiqué organiser son travail en fonction des délais, en se fixant des objectifs quotidiens et en structurant ses journées. Sur l’échelle de régularité d’utilisation des stratégies, la participante mentionne utiliser cette stratégie la plupart du temps (4), résultant cohérente avec ses déclarations dans tous les scénarios. La stratégie « Organisation et transformation » a été citée dans 2 contextes. La participante a expliqué organiser le matériel en élaborant des « cartes mentales » pour établir « des liens entre les différents sujets du cours ». La participante a déclaré utiliser cette stratégie la plupart du temps (4), ce qui confère à cette stratégie un score de cohérence élevé. La stratégie « Répétition et mémorisation » n’a été mentionnée que dans un contexte, la participante indique utiliser cette stratégie occasionnellement (2) et que dans des situations spécifiques, comme pour préparer des examens oraux ou des présentations. En ce qui concerne les stratégies « Examen des dossiers » et « Tenue de registres et suivis », la participante indique les utiliser la plupart du temps (4). Cependant, lors de l’entretien, elle ne les mentionne que dans un seul contexte, ce qui entraîne un score de cohérence relativement bas pour ces stratégies.

Résultats participante 2 (P2):

La participante 2 dispose d’une vaste palette de stratégies d’autorégulation de l’apprentissage, qu’elle adapte en fonction du contexte, mentionnant 9 stratégies sur 10 dans les six contextes. La stratégie « Autoévaluation » n’a été évoquée dans aucun contexte.

La stratégie la plus fréquemment mentionnée par la participante est « Organisation et transformation », présente dans 4 des 6 contextes. La participante a déclaré « faire un plan de travail » pour rédiger des travaux, et « faire des liens avec des connaissances antérieures » tout en organisant son matériel à l’aide de résumés. Sur l’échelle de régularité d’utilisation des stratégies, la participante dit utiliser cette stratégie la plupart du temps (4), ce qui confère à cette stratégie un score de cohérence élevé. La participante dit utiliser la stratégie « Recherche d’aide sociale » occasionnellement (2), en effet elle ne la mentionne que lors d’un contexte et elle se réfère uniquement à l’aide des pairs et non pas à celle des professeur·e·s. Les stratégies « Fixation d’objectifs et planification », « Recherche d’informations » et « Examen des dossiers » ont été mentionnées dans 2 contextes. La participante dit utiliser cette stratégie fréquemment (3), ce qui leur confère un score de cohérence élevé. En ce qui concerne les stratégies « Tenue de registres et suivi » et « Structuration de l’environnement », la participante a déclaré les utiliser la plupart du temps (4). Cependant, elle ne les mentionne que dans un seul contexte, ce qui confère à ces stratégies un score de cohérence faible.

La plupart des réponses des deux participantes montrent une cohérence entre la régularité d’utilisation mentionnée par les participantes et la fréquence dans laquelle elles les mentionnent à travers les différents contextes, ce qui suggère une conscience métacognitive de leur part. En ce qui concerne les stratégies qui présentent un faible score de cohérence interne, il serait intéressant d’explorer davantage leur utilisation, il pourrait s’agir d’un simple oubli, ou peut-être d’une perception différente de leur utilisation dans les divers contextes d’apprentissage.

Discussion sur l’outil de mesure

Les 14 stratégies proposées par Zimmerman et Martinez-Pons (1986), ont toutes été mentionnées dans au moins un contexte par au moins une des participantes. Cela reflète la pertinence des stratégies proposées par les auteurs et le fait que l’outil SRLIS permet effectivement d’évaluer l’utilisation de ces stratégies, renforçant ainsi la validité de l’outil.

Pour utiliser le SRLIS une expérience préalable semble essentielle pour obtenir des résultats pertinents et complets. Lors des entretiens, j’ai parfois omis de demander la régularité d’utilisation des stratégies ou de relancer la discussion avec des questions de clarification. En conséquence, les résultats de mes interviews doivent être interprétés avec prudence. Souvent, les participantes ne mentionnaient qu’une seule stratégie par contexte. Avec le recul, je réalise que j’aurais dû poser des questions supplémentaires pour les inciter à réfléchir davantage sur les stratégies d’apprentissage mobilisées. Cela aurait permis d’obtenir des résultats plus exhaustifs et de renforcer leur validité. Il semble qu’une formation systématique des évaluateur·trice·s et une procédure de codage standardisée permettent de recueillir des informations fiables sur les stratégies d’autorégulation des étudiant·e·s (Zimmerman et Martinez-Pons, 1986).

Il est intéressant de constater que presque pour chaque stratégie mentionnée les participantes disent les utiliser fréquemment (3) ou la plupart du temps (4), cela peut refléter le fait que les participantes ont mentionnée que les stratégies qu’elles utilisent souvent en oubliant de mentionner celles moins utilisées. Cela peut également refléter une difficulté à autoévaluer la régularité de l’utilisation de chaque stratégie ou peut-être dû au biais de désirabilité, qui peut également affecter les réponses des participant·e·s.

Lors de la discussion post-interview, mes participantes ont partagé certaines difficultés rencontrées. Elles ont relevé un manque de clarté dans certains contextes. Par exemple, le contexte 3 faisait référence aux « devoirs universitaires », mais les deux participantes ont précisé que cela pouvait varier considérablement selon le type de travail : s’agissait-il d’un travail à rédiger, d’une présentation, ou d’un devoir de statistique ? Pour augmenter la validité du test, il aurait été pertinent d’adapter les contextes pour les rendre plus spécifiques à l’environnement universitaire, par exemple en fournissant des exemples concrets davantage ancrés dans la réalité des étudiante·e·s de l’université, comme la rédaction d’un travail de master ou de bachelor.

Concernant la fidélité, celle-ci reste limitée dans cette étude, car j’ai été la seule personne à coder les données selon les catégories d’autorégulation de l’apprentissage. Afin d’améliorer la fidélité, il serait nécessaire d’avoir au moins deux évaluateur·trice·s qui codent les données de manière indépendante et de viser un niveau d’accord inter-juge (Bandalos, 2018).

2. MAI : Metacognitive Awarness Inventory

Description de l’outil

Le MAI, développé par Schraw et Dennison (1994), est un instrument d’autoévaluation quantitatif qui permet de mesurer les deux composantes de la conscience métacognitive chez les adultes : la connaissance et la régulation de la cognition.

Le MAI prend la forme d’un questionnaire d’autoévaluation d’une durée d’environ 10 minutes et comprend 52 items répartis en huit sous-composantes regroupées en fonction des deux dimensions de la métacognition (G. Schraw et Dennison, 1994).

- La connaissance de la cognition : ce que nous savons de nos propres processus cognitifs, tels que les connaissances déclaratives (DK), les connaissances procédurales (PK) et les connaissances conditionnelles (CK).

- La régulation de la cognition : les sous-processus qui facilitent l’aspect de contrôle de l’apprentissage et des processus cognitifs, tels que la planification (P), les stratégies de gestion de l’information (IMS), le monitorage (M), les stratégies de débardage (DS) et l’évaluation de l’apprentissage (E).

Description de la méthodologie

Dans la page initiale du questionnaire en ligne, les participantes ont été informées des objectifs et du déroulement de l’étude, ainsi que du fait que leurs réponses seraient anonymisées et que toutes les informations fournies seraient traitées de manière strictement confidentielle. Ensuite, elles ont répondu à quelques questions concernant les données démographiques à savoir : âge, genre, faculté, niveau d’études.

Le questionnaire comportait 52 affirmations et les participantes étaient appelées à indiquer dans quelle mesure chaque déclaration leur correspondait sur une échelle de Likert allant de 0 = « pas du tout typique de moi » à 10 = « très typique de moi ».

Les réponses ont été analysées de manière quantitative, les moyennes des deux composantes de la métacognition ainsi que des huit sous-composantes ont été calculés et discutés.

Présentation des résultats

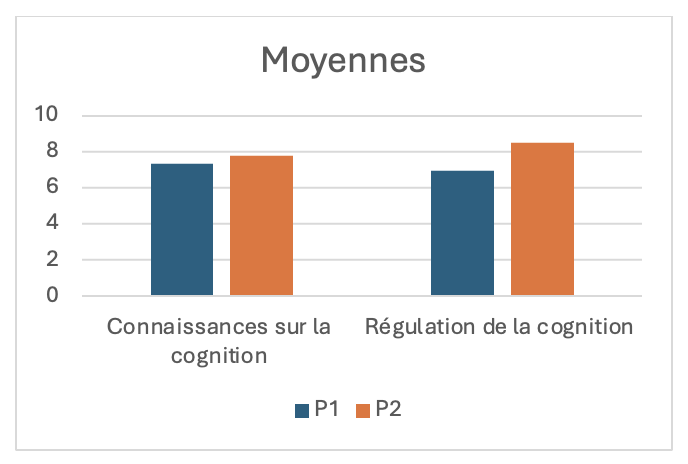

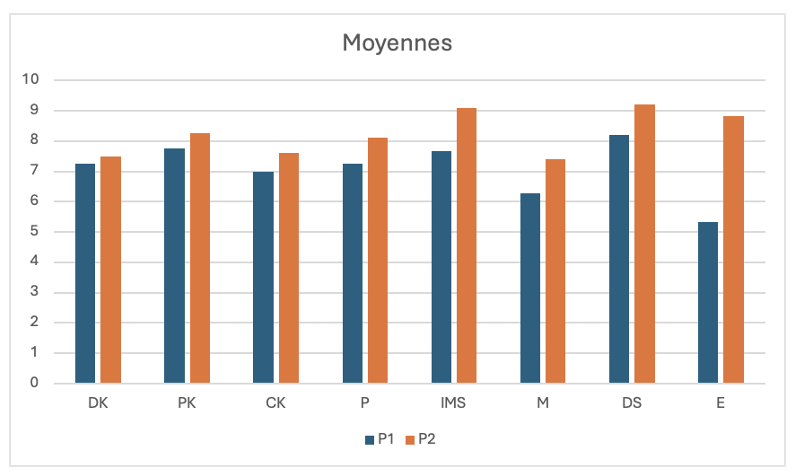

Cette participante obtient des scores élevés dans la plupart des sous-composantes de la métacognition, indiquant des solides compétences métacognitives. Elle obtient un score de 7,33 dans la connaissance de la cognition, ce qui indique qu’elle est consciente de ses processus cognitifs et possède une bonne connaissance de ses stratégies d’apprentissage.

Dans la régulation de la cognition, la participante obtient un score de 6,94. Ce score est assez élevé, mais il laisse entrevoir qu’il y a des domaines qui pourraient être améliorés. La P1 se distingue particulièrement dans les stratégies de débardage (DS), ce qui indique qu’elle utilise régulièrement des stratégies pour résoudre les difficultés rencontrées durant son apprentissage. Cependant, elle présente un score plus faible en évaluation de l’apprentissage (E) et en monitorage (M). Cela suggère qu’elle rencontre des difficultés à évaluer de manière adéquate ses propres performances et à surveiller ses apprentissages. Bien que la P1 présente de bonnes compétences métacognitives, elle pourrait bénéficier d’une aide supplémentaire dans les sous-composantes de l’évaluation et le monitorage. Cela pourrait améliorer sa régulation de la cognition et par conséquent ses performances académiques (Young et Fry, 2008).

Cette participante a des scores élevés dans toutes les sous-composantes de la métacognition, indiquant des solides compétences métacognitives. Cela n’indique pas seulement une solide connaissance et compréhension se ses processus cognitifs, mais aussi une bonne capacité à réguler ces processus pour atteindre ses objectifs d’apprentissage.

La participante obtient un score élevé dans les stratégies de débardage (DS) et les stratégies de gestion de l’information (IMS). Ce qui indique une bonne capacité à utiliser des stratégies lui permettent de résoudre les difficultés et des techniques pour organiser, mémoriser et gérer l’information. Pour améliorer sa régulation de la cognition et ses performances académiques, cette participante pourrait travailler sur ses stratégies de monitorage (Young et Fry, 2008).

Les deux participantes obtiennent des scores relativement similaires dans la connaissance sur la cognition. Cependant, il y a une différence notable dans les scores de régulation de la cognition, la P2 obtient un score global plus élevé que la P2. Ces résultats rejoignent ceux de Schraw (1994) qui a trouvé que les apprenant·e·s adultes ont tendance à différer en ce qui concerne l’utilisation des compétences en régulation métacognitive, mais pas autant en ce qui concerne les compétences en connaissance métacognitive.

Discussion sur l’outil de mesure

Le MAI est plus facile et moins coûteux à utiliser que d’autres outils de mesure de la conscience métacognitive (G. Schraw et Dennison, 1994). Son format standardisé permet d’évaluer rapidement la conscience métacognitive d’un grand nombre de personnes, offrant une vue globale des forces et des faiblesses métacognitives des individus. Les résultats obtenus permettent de mettre en place des stratégies ciblées pour améliorer ces compétences (Young et Fry, 2008).

Cependant, l’utilisation du MAI comporte plusieurs limites à prendre en compte. Étant basé sur l’autoévaluation subjective, les résultats peuvent être influencés par la tendance des participant·e·s à sous-estimer ou surestimer leurs capacités. Par exemple, la P1 n’a jamais attribué le score maximal de 10, tandis que la P2 l’a utilisé à plusieurs reprises. Cette différence peut refléter une interprétation subjective des scores. En outre, les autoévaluations des stratégies métacognitives peuvent être influencées par des événements d’apprentissage récents, ce qui peut biaiser les réponses des participant·e·s (Greene et Azevedo, 2010). Il est donc important de contextualiser les résultats et d’en tenir compte lors de leur analyse. Dans le MAI, des biais tels que l’acquiescement et le désir de plaire peuvent également affecter les réponses (Harrison et Vallin, 2018).

Un autre biais potentiel réside dans le format en ligne du questionnaire, car les conditions de réponse sont inconnues et il est difficile de savoir si les participant·e·s ont réfléchi sérieusement à leurs processus d’apprentissage, ou s’ils·elles ont répondu de manière rapide et superficielle. Ainsi, ces différents biais peuvent limiter la fidélité de l’outil.

En ce qui concerne la validité, certaines recherches remettent en question la capacité du MAI à mesurer la métacognition de manière exhaustive et précise. Une étude a démontré que le modèle d’origine, qui repose sur huit sous-dimensions théoriques proposées par Schraw et Dennison (1994), est difficile à confirmer empiriquement (Harrison et Vallin, 2018). Les analyses factorielles suggèrent que les données s’adaptent mieux à un modèle simplifié, composé de deux domaines principaux : la connaissance et la régulation de la cognition, ou même à un modèle avec un nombre réduit d’items. En effet, certains items du MAI manquent de clarté et présentent des variations significatives dans leurs seuils de réponse, ce qui peut compromettre sa validité en tant qu’outil d’évaluation de la métacognition (Harrison et Vallin, 2018).

En raison de ces limites liées à la fidélité et à la validité, le MAI doit être utilisé avec prudence. Pour évaluer de manière plus robuste la conscience métacognitive, il est préférable de combiner plusieurs méthodes d’évaluation plutôt que de s’appuyer exclusivement sur un outil unique comme le MAI (Harrison et Vallin, 2018).

3. Comparaison SRLIS et MAI

Les outils SRLIS et MAI partagent un objectif commun : évaluer des dimensions de l’apprentissage autorégulé. Cependant, ils se distinguent par leur approche, leur mise en œuvre et leur perspective, ce qui les rend potentiellement complémentaires.

Le MAI, sous forme de questionnaire, offre une évaluation globale et quantitative de la conscience métacognitive. En revanche, le SRLIS, qui se base sur des entretiens, permet d’explorer plus en profondeur les stratégies utilisées pour réguler l’apprentissage. La combinaison de ces deux outils pourrait offrir une perspective plus riche et une analyse plus complète de l’apprentissage autorégulé, à condition d’être vigilant face aux biais des deux outils.

L’analyse des données de mon échantillon relève des cohérences et des incohérences entre les deux outils. Par exemple, la P1 a obtenu un score élevé dans la catégorie « Planification » du MAI et elle a mentionné la stratégie « Fixation d’objectifs et planification » dans 4 contextes du SRLIS. Cette correspondance suggère une cohérence entre les deux outils. Au contraire, la P2 a obtenu un score assez élevé dans la catégorie « Évaluation » du MAI, mais elle n’a jamais mentionné la stratégie « Autoévaluation » dans le SRLIS. Cette divergence peut relever des limites dans la manière dont les deux outils évaluent certains aspects de la régulation.

Pour que ces deux outils soient complémentaires, il est nécessaire de les affiner, comme par exemple éliminer les items du MAI qui manquent de clarté (Harrison et Vallin, 2018). Ainsi, une réflexion approfondie sur la manière de croiser ces deux outils, en tenant compte des biais et des limites, pourrait permettre d’obtenir une évaluation plus complète de l’autorégulation de l’apprentissage.

4. Conclusion

Ce travail met en évidence la complexité de l’évaluation de l’apprentissage autorégulé et de la conscience métacognitive. Ces processus internes ne sont pas directement observables et sont exposés à divers biais liés à l’autoévaluation, tels que la désirabilité sociale, la variation dans l’interprétation des questions, ou encore la disponibilité et la capacité des participant·e·s à réfléchir sur leurs apprentissages. Ainsi, une question centrale émerge : comment évaluer de manière fiable et valide l’apprentissage autorégulé ?

Pour y répondre, il est essentiel de poursuivre une évaluation continue et rigoureuse des outils existants. Une mise à jour régulière de ces instruments, intégrant les avancées scientifiques et les retours d’expérience sont essentiels pour garantir la validité et la fiabilité. De plus, lors de l’interprétation des données, il est important de prendre en compte les biais susceptibles d’influencer ces outils.

Nous avons montré que les outils SRLIS et MAI peuvent être complémentaires. Une réflexion en découle: comment combiner de manière optimale le SRLIS er la MAI pour obtenir une évaluation complète de l’apprentissage autorégulé ?

Bibliographie

- Bandalos, D. L. (2018). Measurement theory and applications for the social sciences. The Guilford Press.

- Greene, J. A. (2018). Self- Regulation in Education. Routledge.

- Greene, J. A. et Azevedo, R. (2010). The Measurement of Learners’ Self-Regulated Cognitive and Metacognitive Processes While Using Computer-Based Learning Environments. Educational Psychologist, 45(4), 203‑209. https://doi.org/10.1080/00461520.2010.515935

- Hacker, D. J. (1998). Definitions and empirical foundations. Dans Metacognition in educational theory and practice (p. 1‑23). Lawrence Erlbaum Associates.

- Harrison, G. M. et Vallin, L. M. (2018). Evaluating the metacognitive awareness inventory using empirical factor-structure evidence. Metacognition and Learning, 13(1), 15‑38. https://doi.org/10.1007/s11409-017-9176-z

- Pintrich, P. R. (1999). The role of motivation in promoting and sustaining self-regulated learning. International Journal of Educational Research, 31(6), 459‑470. https://doi.org/10.1016/S0883-0355(99)00015-4

- Pintrich, P. R. (2000). The Role of Goal Orientation in Self-Regulated Learning. Dans Handbook of Self-Regulation (p. 451‑502). Elsevier. https://doi.org/10.1016/B978-012109890-2/50043-3

- Schraw, G. et Dennison, R. S. (1994). Assessing metacognitive awareness. Contemporary educational psychology, 19(4), 460‑475. https://doi.org/10.1006/ceps.1994.1033

- Schraw, Gregory. (1994). The effect of metacognitive knowledge on local and global monitoring. Contemporary educational psychology, 19(2), 143‑154. https://doi.org/10.1006/ceps.1994.1013

- Young, A. et Fry, J. D. (2008). Metacognitive awareness and academic achievement in college students. Journal of the Scholarship of Teaching and Learning, 8(2).

- Zimmerman, B. J. et Martinez-Pons, M. (1986). Development of a Structured Interview for Assessing Student Use of Self-Regulated Learning Strategies. American Educational Research Journal, 23(4), 614‑628. https://doi.org/10.3102/00028312023004614

- Zimmerman, B. J. et Martinez-Pons, M. (1988). Construct Validation of a Strategy Model of Student Self-Regulated Learning, 80(3), 284‑290. https://psycnet.apa.org/doi/10.1037/0022-0663.80.3.284

[1] Annexe 1 « Contextes d’apprentissage autorégulé »