Auteur : Inès Desaulty

Introduction

Au cours des dernières décennies, la recherche en éducation s’est intéressée de près à l’apprentissage auto-régulé des apprenant.e.s. Selon Schunk et Greene (2017), l’auto-régulation correspond à la manière dont les apprenant.e.s « activent et maintiennent systématiquement leurs cognitions, motivations, comportements et affects, en vue d’atteindre leurs objectifs » (Schunk et Greene, 2017, p. 1). Les compétences d’auto-régulation sont ainsi essentielles afin de guider l’apprentissage des élèves pendant et après leur scolarité, mais aussi pour s’auto-éduquer tout au long de leur vie (Boekaerts, 1997). Pour ce faire, les apprenant.e.s ont recours à tout un panel de stratégies d’apprentissage. Les chercheurs en éducation ont réalisé différents modèles cognitifs et métacognitifs permettant de distinguer les différents types de stratégies d’apprentissage (Büchel, 1996; Flavell, 1979; Nelson, 1990). En plus des modèles purement cognitifs et métacognitifs, l’intégration de dimensions motivationnelles est l’approche qui prime aujourd’hui dans les modèles de l’apprentissage autorégulé (Berger et Büchel, 2012). Parmi les modèles d’apprentissage autorégulé intégrant métacognition et motivation, nous pouvons citer ceux de Borkowski et al. (2000) et Pintrich (2004). Berger et Büchel (2012), soulignent que les apprenant.e.s doivent être capables de développer des croyances motivationnelles favorables pour que leur engagement continu devienne optimal et que leur potentiel d’apprentissage se déploie complètement.

Dans ce travail, il est question d’étudier de plus près les processus d’autorégulation de l’apprentissage au travers de deux outils de mesure : le SRLIS (Self-Regulated Learning Interview Schedule) et le MSLQ (Motivated Strategies for Learning Questionnaire). Chacun de ces outils de mesure permet d’interroger des apprenant.e.s quant à l’autorégulation de leur apprentissage, en se concentrant sur des dimensions différentes. Le SRLIS interroge l’utilisation des stratégies des apprenant.e.s à partir de contextes d’apprentissage différents. Le MSLQ évalue les orientations motivationnelles des étudiant.e.s et leur utilisation de différentes stratégies d’apprentissage pour un cours spécifique. De ce fait, deux étudiant.e.s de niveau tertiaire seront interrogé.e.s à partir de ces outils et leurs résultats seront analysés dans ce travail. Le travail en duo, avec l’aide d’un collègue ayant utilisé les deux mêmes outils pour son travail, permet de faire des comparaisons à partir des résultats obtenus et de remettre en perspective ce qui ressort des entretiens.

1. Le SRLIS

1.1. Description de l’outil

Le Self-Regulated Learning Interview Schedule (traduisible en français par « protocole d’entretien sur l’apprentissage auto-régulé »), plus communément appelé SRLIS, est un instrument réalisé par Zimmerman et Pons (1986), dans le but d’évaluer l’apprentissage auto-régulé des apprenant.e.s. L’instrument prend la forme d’un entretien structuré lors duquel les apprenant.e.s répondent à des questions ouvertes concernant des contextes d’apprentissage différents illustrés par six scénarios. Les apprenant.e.s répondent spontanément aux questions, mais des relances peuvent être proposées en cas de problèmes. L’instrument est, au départ, pensé pour un public d’apprenant scolarisé au secondaire II (High School aux États-Unis), or, dans le cadre de ce travail, les scénarios et questions ont été adapté pour un public du niveau tertiaire (Universités et Hautes Écoles). Ainsi, les six scénarios adaptés présentent les situations suivantes : étudier en situation de classe, rédiger des devoirs évalués, compléter des devoirs universitaires, préparer des examens, étudier lors d’une baisse de motivation, étudier à domicile. Zimmerman et Pons (1986), sur la base de la recherche scientifique et de travaux précédents, ont identifié 14 catégories de stratégies d’auto-régulation des apprentissages : auto-évaluation (1), organisation et transformation (2), fixation d’objectifs et planification (3), recherche d’informations (4), tenue de registre et suivi (5), structuration de l’environnement (6), conséquences personnelles (7), répétition et mémorisation (8), recherche d’aide sociale envers les pairs, enseignant.e.s, adultes (9-11), révision des informations (12-14). Une quinzième catégorie, nommée « Autres », regroupe les stratégies qui ne concernent pas des comportements d’auto-régulation.

1.2. Description de l’échantillon

La population cible de ce travail est les étudiant.e.s du degré tertiaire, soit venant d’universités et hautes écoles. L’échantillon est composé de deux personnes : une étudiante en Bachelor de l’Université de Fribourg âgé de 22 ans ; ainsi qu’un étudiant en Bachelor de la Haute-Ecole d’Ingénierie et de Gestion du Canton de Vaud âgé de 23 ans. Tous deux sont en deuxième année de Bachelor. C’est un échantillon de convenance, car les participant.e.s sont des connaissances qui ont été contactées par WhatsApp. En ce qui concerne le codage des entretiens, l’anonymat des participant.e.s étant garanti, on retrouve deux dénominations différentes pour mentionner les sujets : « M.B » désigne la participante ; « J.D » désigne le participant.

1.3. Description de la méthodologie

Le guide d’entretien commence par une introduction dans laquelle les conditions de passation sont expliquées. Les participant.e.s sont averti.e.s que l’entretien dure environ 20 minutes et est enregistré. Puis, une brève explication est donnée quant au sujet sur lequel porte les questions de l’entretien. Les sujets devront également renseigner au mieux, la régularité d’utilisation de chaque stratégie évoquée selon une échelle de Likert allant de 1 à 4 (1 = rarement ; 2 = occasionnellement ; 3 = fréquemment ; 4 = la plupart du temps). Les participant.e.s sont invité.e.s à donner leurs informations démographiques et signer le consentement pour l’enregistrement.

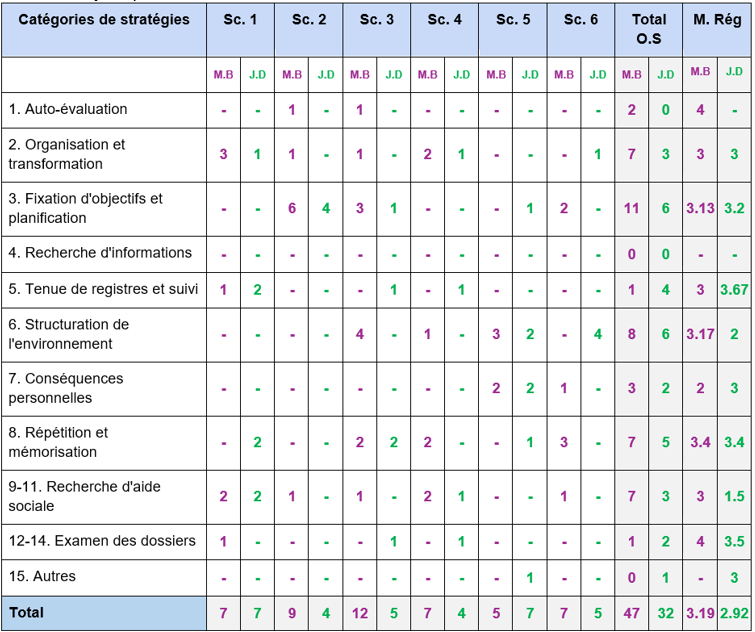

Pour l’analyse des données récoltées durant l’entretien, j’ai procédé à une retranscription fidèle à partir des enregistrements des deux interviews (c.f Annexe 1 et 2) grâce au logiciel sonic.ai. Puis, j’ai réalisé deux grilles d’analyse catégorielle de contenu, une pour chaque participant.e, en reprenant les 14 catégories de stratégies du SRLIS. Les citations des participant.e.s ont ainsi été catégorisées dans les grilles respectives. Quand le participant l’a renseignée, la régularité d’utilisation des stratégies est indiquée entre parenthèses après chaque verbatim. La colonne utilisation des stratégies permet d’indiquer, de façon dichotomique, la présence ou l’absence de stratégies pour une catégorie de stratégies. De plus, la colonne occurrences des stratégies indique le nombre de mentions de stratégies dans la catégorie de stratégies. Ensuite, j’ai réalisé une grille d’analyse quantitative (tableau 1), afin de visualiser quelles catégories de stratégies sont utilisées pour quel scénario. Cette grille quantitative synthétise les données qui se trouvent dans les grilles d’analyse catégorielle de contenu et permet une meilleure vue d’ensemble quant aux types de stratégies utilisées par les participant.e.s à travers les différents scénarios.

1.4. Présentation des résultats

Tableau 1

Grille d’analyse quantitative

Note. Sc. = scénario ; O.S = occurrences des stratégies ; M. Rég = moyenne de la régularité d’utilisation des stratégies

Le tableau 1 permet de visualiser de manière quantitative les résultats des participant.e.s. Les résultats de chaque participant.e sont traités séparément, le but de ce travail n’étant pas de les comparer.

Résultats pour la participante M.B

La participante M.B rapporte avoir recours à 47 stratégies qui font partie de 13 catégories différentes. Cela montre que l’étudiante utilise un large panel de stratégies pour son quotidien à l’université. De plus, la moyenne totale de la régularité d’utilisation des stratégies est plutôt élevée (Mtotalereg= 3.19), ce qui montre que M.B mobilise les stratégies évoquées fréquemment. Premièrement, M.B a besoin de se fixer des objectifs et de planifier les tâches (catégorie 3 ; Mreg = 3). Elle réalise un programme hebdomadaire dans lequel ses tâches sont prévues à des horaires fixes, déterminés en fonction de la charge cognitive. De plus, elle connaît les moments de la journée où elle est la plus efficiente et organise ses journées en fonction de cela. Ensuite, elle fait quotidiennement des to-do listes, et a parfois recours aux minuteurs académiques pour orienter sa concentration sur la tâche. M.B a besoin de structurer son environnement pour étudier (catégorie 6 ; Mreg = 3.17). Elle dit être vite distraite et préfère travailler à l’université ou au bureau de sa mère plutôt que chez elle. Elle écoute de la musique classique (sans paroles) pour rester concentrée et fait des pauses ou s’active quand cela est nécessaire : « Donc je vais m’aérer ou je vais manger un truc. Ou je vais boire un café, ou même je vais marcher des fois ». Troisièmement, la participante rapporte avoir besoin de répéter et mémoriser ses cours (catégorie 8 ; Mreg = 3.4). Elle dit avoir besoin de parler à voix haute pour répéter ses leçons à partir des powerpoints de ses cours ou de fiches qu’elle a réalisé en amont. Elle explique aussi qu’elle révise ses examens oraux soit en se racontant une histoire, soit à l’aide de mots-clés : « je mets dans mon support de brouillon, genre deux mots-clés et après je dois reformuler toute ma phrase autour de ces deux mots. […] En fait, je diminue chaque fois le nombre de mots ». De plus, elle répète ses leçons en s’imaginant être une enseignante donnant un cours à ses élèves. Enfin, M.B recherche l’aide d’autrui pour étudier (catégories 9, 10 et 11 ; Mreg = 3). Elle mobilise l’aide de ses camarades en organisant des sessions de révision par groupe ou en se posant des questions, mais également de ses enseignants en leur posant également des questions, ou encore de ses parents avec lesquels elle discute de ce qu’elle a appris pour réviser ses cours.

Résultats pour le participant J.D

Le participant J.D rapporte avoirs recours à 32 stratégies qui font partie de 13 catégories différentes. De plus, la moyenne totale de la régularité d’utilisation des stratégies est modérée (Mtotalereg=2.92), ce qui montre que J.D mobilise les stratégies évoquées occasionnellement. Premièrement, J.D planifie systématiquement ses tâches et se fixe parfois des objectifs (catégorie 3 ; Mreg = 3.2). En effet, il utilise un outil « notion » comme calendrier pour noter ce qu’il doit faire et les différentes deadlines. Il effectue ensuite son travail en fonction de ces deadlines. J.D explique également avoir besoin de structurer occasionnellement son environnement afin d’étudier (catégorie 6 ; Mreg = 2). Bien qu’il fasse rarement des pauses, J.D explique qu’il a besoin d’avoir un espace de travail rangé et nettoyé pour étudier convenablement et qu’il préfère travailler chez lui plutôt qu’à son école. Cependant, il essaie d’éviter de travailler dans sa chambre et préfère le faire dans un espace prévu pour lui, son établi au sous-sol. Troisièmement, J.D utilise tout un tas de stratégies différentes pour répéter et mémoriser ses cours (catégorie 8 ; Mreg = 3.4). En effet, il revoit les prises de notes de ses cours en fonction de sa compréhension de la thématique : « Si je suis dans une branche où ça va assez vite, ça va assez bien, je ne regarde pas forcément toujours mes notes à la maison, je vais les ressortir quand il y a un travail écrit je vais les relire. » De plus, pour réviser un examen, il refait systématiquement des séries d’exercices ou relit ses notes jusqu’à maîtriser pleinement la matière. On peut donc voir que J.D est un étudiant qui aura tendance à revoir ses notes, exercices, et supports de cours pour étudier, sans forcément avoir besoin de réorganiser la matière pour se l’approprier. Il explique que ce qui compte pour lui, c’est « donner du sens » à ce qu’il apprend.

Les deux participant.e.s sont, de ce fait, bien différents dans leur façon d’étudier. Cela pourrait s’expliquer par la nature de leurs études. En effet, M.B effectue des études à l’université, et J.D en haute école d’ingénierie, deux cursus tertiaires qui diffèrent quant aux modalités d’évaluations et à leur organisation. A l’université, les examens se font le plus souvent à la fin du semestre ou année, alors qu’en haute école d’ingénierie, le contrôle continu est la modalité d’évaluation utilisée.

1.5. Discussion sur l’outil de mesure

La validité du SRLIS a été testée par Zimmerman et Martinez-Pons (1988). Les chercheurs ont pu confirmer plusieurs validités : validité convergente ; et validité discriminante. Premièrement, une corrélation significative (r. = .70) a été trouvée entre les résultats du SRLIS issus des entretiens avec les étudiant.e.s, et les observations des enseignant.e.s sur leurs comportements d’auto-régulation. Cela atteste de la validité convergente de l’outil et donc que le SRLIS mesure le même construit, soit l’apprentissage auto-régulé. Deuxièmement, les résultats ont révélé que le SRLIS permet de distinguer l’apprentissage auto-régulé des compétences générales (soit les performances aux tests standardisés ou la verbosité des apprenant.e.s). Cela atteste de la validité discriminante du SRLIS et qu’il mesure bel et bien les stratégies d’apprentissage et non autre chose.

D’après mon expérience, l’utilisation du SRLIS sur les deux étudiant.e.s de cet échantillon a permis de dégager les différentes stratégies d’auto-régulation mise en place par ceux-ci. On retrouve 13 des 14 catégories de stratégies. Cependant, quelques éléments pourraient remettre en question la validité et la fidélité des résultats de ce travail. Premièrement, lors du codage des verbatims, certains éléments pouvaient être classés dans plusieurs catégories à la fois. Cela signifierait soit que les catégories ne sont pas suffisamment solides, soit que le système de codage est à revoir. Pour pallier ces problèmes, il faudrait avoir plus de précisions quant aux conditions de catégorisation, ou alors que plusieurs personnes effectuent la catégorisation afin d’accéder à un niveau convenable d’accords interjuges (Bandalos, 2018). Deuxièmement, l’échantillon est composé uniquement de deux étudiant.e.s dont le contexte d’étude est différent. Les stratégies rapportées sont multiples ce qui rend la comparaison difficile. Il aurait fallu choisir deux étudiant.e.s de mêmes contextes ou bien ajouter deux étudiant.e.s supplémentaires à l’échantillon afin de balancer cet effet. Deuxièmement, certains scénarios n’étaient pas compris d’office par les participant.e.s et des explications supplémentaires et exemples ont dûs être donnés. De plus, la subjectivité du chercheur pourrait avoir biaisé les résultats. En effet, il était parfois nécessaire de poser des questions supplémentaires pour explorer davantage ce que la personne exprimait. Tous ces éléments pourraient avoir orienté les étudiant.e.s dans les réponses données.

Enfin, selon mon expérience et celle de ma collègue de travail, le SRLIS est un bon outil de mesure pour évaluer l’apprentissage auto-régulé des apprenant.e.s car il a permis de faire état des nombreuses stratégies d’auto-régulation que les étudiant.e.s de l’échantillon utilisent. Cependant, son adaptation, proposée pour un public d’étudiant.e.s de niveau tertiaire, pourrait être revue, surtout la formulation des différents scénarios.

2. Le MSLQ

2.1. Description de l’outil

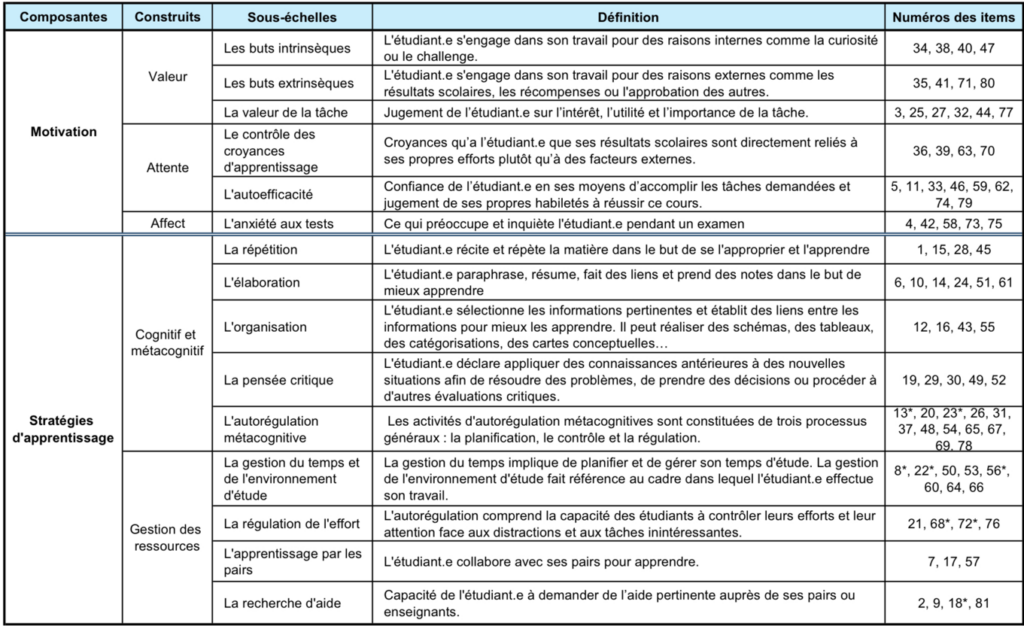

Tableau 2

Composition du MSLQ (adapté de Ménard et Legault, 2010 ; Pintrich et al., 1991)

Note. Les numéros des items correspondent à mon adaptation du questionnaire. Les items avec une astérisque (*) correspondent aux items inversés.

Le Motivated Strategies for Learning Questionnaire (MSLQ, et traduisible en français par « questionnaire sur les stratégies de motivation pour l’apprentissage ») est un questionnaire d’auto-évaluation réalisé par Pintrich et al. (1991), ayant pour objectif de mesurer les orientations motivationnelles des étudiant.e.s et leur utilisation des stratégies d’apprentissage pour un cours universitaire spécifique. Le questionnaire est composé de 81 items et séparé en deux sections. La première section porte sur la motivation, comprend 31 items, et est séparée en six sous-échelles : les buts extrinsèques, les buts intrinsèques, la valeur de la tâche, le contrôle des croyances d’apprentissage, l’autoefficacité, et l’anxiété aux tests. La deuxième section porte sur les stratégies d’apprentissage, comprend 50 items, et est séparée en neuf sous-échelles : la répétition, l’élaboration, l’organisation, la pensée critique, l’autorégulation métacognitive, la gestion du temps et de l’environnement d’étude, la régulation de l’effort, l’apprentissage par les pairs, et la recherche d’aide. Le tableau 2 résume la composition du MSLQ. Pour chaque item, les étudiant.e.s s’autoévaluent à partir d’une échelle de Likert allant de 1 à 7 (1 = ne me correspond pas du tout ; 7 = me correspond entièrement). Parmi les 81 items, huit sont des items inversés : 8, 13, 18, 22, 23, 56, 68, 72. Cela signifie que les questions sont formulées négativement et donc que l’échelle doit être inversé pour révéler le bon score des participant.e.s[1].

2.2. Description de la méthodologie

Les participant.e.s sont informé.e.s que le questionnaire prend entre 15 à 20 minutes à être rempli, et que les données seront anonymisées. De plus, ils sont invités à renseigner leurs informations démographiques. Ensuite, une courte explication est donnée sur le questionnaire et son utilité. Les étudiant.e.s doivent penser à un cours spécifique pour répondre aux questions, et ne surtout pas changer pendant le processus.

Pour l’analyse des données récoltées par le questionnaire, j’ai tout d’abord inséré les réponses des participant.e.s, en score de 1 à 7, pour chacun des items dans un tableau Excel. J’ai veillé préalablement à modifier l’échelle pour les huit items considérés comme inversés. Ensuite, j’ai calculé les moyennes pour chaque sous-échelle, à partir des scores aux items qui les composent. Enfin, afin de simplifier la lecture des résultats, j’ai réalisé des graphiques à l’aide du logiciel Python.

2.3. Présentation des résultats

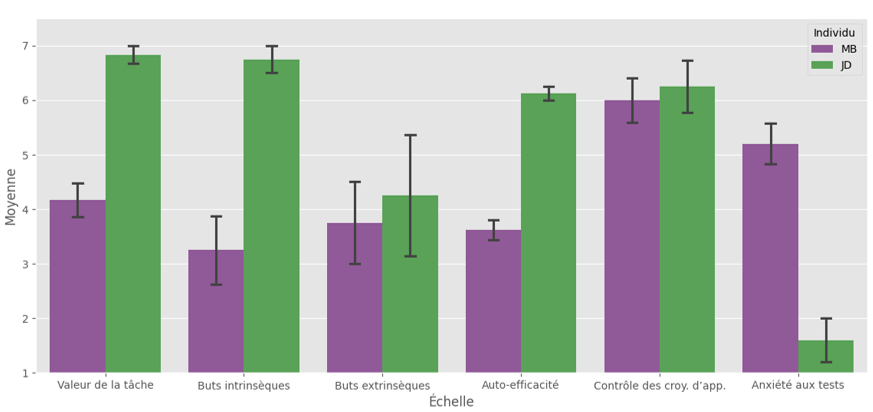

A partir du graphique 1, on peut voir que les profils motivationnels des participant.e.s sont bien différents. En effet, J.D a des moyennes élevées (entre 6 et 7) dans toutes les dimensions sauf dans deux : buts extrinsèques et anxiété aux tests. En effet, il a une moyenne plus élevée pour les buts intrinsèques, que pour les buts extrinsèques, ce qui signifie que J.D s’engage dans son travail pour des raisons internes comme le challenge ou la curiosité plutôt que des raisons externes comme les notes ou les récompenses. La participante M.B, a des moyennes de score modérées (entre 3 et 4). Les scores sont plus élevés (entre 5 et 6) dans les dimensions anxiété aux tests et contrôle des croyances d’apprentissage. Cela signifie que la participante croit fortement que ce sont ses efforts et son travail qui lui permettent de réussir et de bien apprendre.

Graphique 1

Résultats des participant.e.s pour les sous-échelles de la motivation

Note. Les barres représentent l’erreur standard

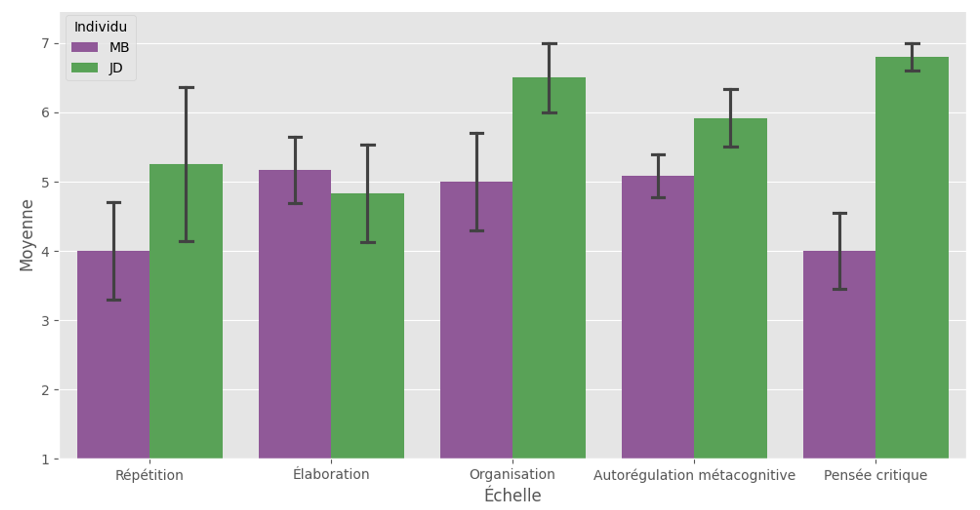

Concernant les résultats pour les stratégies d’apprentissage au niveau du construit cognitif et métacognitif, on peut voir, à l’aide du graphique 2, que les participants ont des scores plutôt modérés à élevés (entre 4 et 6,8). Pour la participante M.B, la dimension la plus forte est l’élaboration (5,16) ce qui signifie qu’elle se réapproprie la matière par exemple en prenant des notes, en les résumant, en créant des liens. Les sous-échelles de l’organisation et de l’autorégulation métacognitive sont également assez élevées (5 et 5,08). Le participant J.D a des résultats relativement élevés (entre 4,8 et 6,8). La pensée critique (6,8) et l’organisation (6,5) sont les sous-échelles aux scores les plus hauts. On peut donc voir que J.D mobilise ses connaissances antérieures pour les adapter à de nouvelles connaissances, dans le but de résoudre des problèmes, ou évaluer des situations. De plus, J.D trie les informations essentielles et établit des connexions entre elles pour optimiser son apprentissage et structurer ses idées (schémas, tableaux, cartes conceptuelles).

Graphique 2

Résultats des participant.e.s pour les stratégies d’apprentissage : construit du cognitif et métacognitif

Note. Les barres représentent l’erreur standard

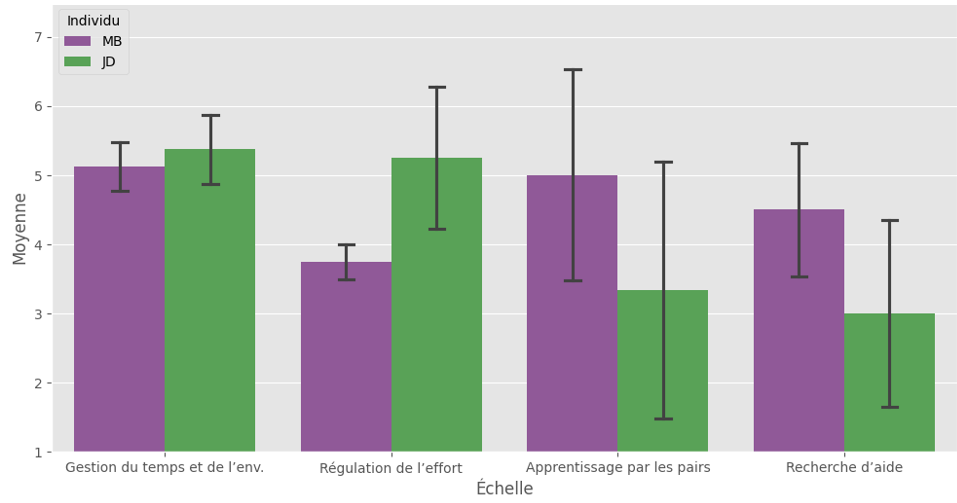

Enfin, par rapport aux résultats pour les stratégies d’apprentissage au niveau de la gestion des ressources, on peut voir, à l’aide du graphique 3, que les participants ont des scores plutôt modérés (entre 3 et 5,38). Le principal constat est que J.D et M.B ont tous deux des résultats respectivement similaires dans les sous-échelles apprentissage par les pairs et recherche d’aide (3,3 et 3 pour J.D ; 4,5 et 5 pour M.B).

Graphique 3

Résultats des participant.e.s pour les stratégies d’apprentissage : construit de la gestion des ressources

Note. Les barres représentent l’erreur standard

2.4. Discussion sur l’outil de mesure

Différents travaux se sont intéressés à la validité et à la fiabilité du MSLQ (Berger et Karabenick, 2011; de Araujo et al., 2023; Pintrich et al., 1991). De Araujo et al. (2023) ont réalisé une analyse factorielle confirmatoire sur les 81 items du MSLQ en prenant en compte les erreurs méthodologiques constatées dans plusieurs études précédentes. L’étude a apporté des preuves attestant la validité structurelle de l’outil. Concernant la fiabilité, 12 des 15 catégories présentent une fiabilité acceptable[2]. Les auteurs avancent la nécessité d’augmenter le nombre d’items pour les catégories aux indices de fiabilité faible afin de la renforcer.

A partir de mon expérience, les étudiant.e.s de mon échantillon ont tous les deux signalé que questionnaire était long, ce qui a provoqué une non-relecture de leurs résultats. Pour remédier à ce problème, on pourrait envisager de proposer à nos étudiant.e.s une version simplifiée du MSLQ, ceci ayant été fait par certains chercheurs (Soemantri et al., 2018; Wang et al., 2023). Un autre problème signalé par les participant.e.s est qu’il ne savait pas comment répondre lorsqu’un l’item ne s’appliquait pas au cours spécifique choisi. En effet, dans le MSLQ, l’étudiant.e est obligé de se positionner selon l’échelle de Likert. Pourtant, répondre lorsqu’un item ne s’applique pas aux spécificités du cours viendrait plutôt à fausser les résultats de l’étudiant.e car cela ne reflète pas la réalité des dimensions motivationnelles et des stratégies d’apprentissage mobilisées par l’étudiant.e. Cela relèverait donc d’un problème de validité du questionnaire. Il serait envisageable de proposer aux étudiant.e.s de cocher la réponse « ne correspond pas à mon cours ».

Enfin, à partir du croisement des analyses avec mon binôme, nous avons toutes deux constatées que nos quatre participant.e.s présentaient des scores respectivement similaires aux catégories recherche d’aide et apprentissage par les pairs. Nous nous interrogeons donc sur la contiguïté de ces deux dimensions et si elles mesurent deux choses différentes.

3. Comparaison entre le SRLIS et le MSLQ

Le SRLIS et le MSLQ, bien qu’ils aient tout deux comme objectif d’évaluer l’apprentissage autorégulé des apprenant.e.s, diffèrent de manière significative dans leurs méthodologies, structures et dimensions explorées. Le SRLIS est basé sur un entretien structuré à partir de différents contextes, et permet d’explorer de manière qualitative le panel de stratégies d’apprentissage mobilisées par les apprenant.e.s dans leur quotidien académique. Quant au MSLQ, c’est un questionnaire auto-rapporté quantitatif qui, à partir d’échelles standardisées, permet de relever les stratégies d’apprentissage et les orientations motivationnelles utilisées par l’apprenant.e pour un cours spécifique de son choix.

En croisant les résultats obtenus aux deux outils, on peut identifier des tendances similaires mais également quelques divergences. Dans le MSLQ et le SRLIS, certaines catégories sont similaires telles que : l’organisation, la gestion du temps/structuration de l’environnement, la répétition et la recherche d’aide. Ces catégories permettent de comparer les résultats des participant.e.s aux deux outils. J.D et M.B obtiennent des résultats assez similaires à ces catégories comparables. Toutefois, il existe quand même des différences. Par exemple, le participant J.D obtient une moyenne élevée de 6,5/7 dans la catégorie organisation, pourtant dans le SRLIS il n’évoque que trois stratégies parmi tous les scénarios pour cette même catégorie. Il est également possible d’identifier des correspondances entre d’autres catégories des deux outils. Par exemple, pour J.D dans le MSLQ, la catégorie la plus élevée est la pensée critique, résultat que l’on retrouve dans le SRLIS car il évoque à de nombreuses reprises qu’il apprend en faisant des liens avec ses expériences et apprentissages passés.

Le SRLIS permet ainsi une analyse approfondie des stratégies d’apprentissage grâce aux réponses ouvertes détaillées par les participant.e.s et peut révéler des nuances contextuelles que le MSLQ ne capture pas. Cependant, la méthodologie qualitative est plus chronophage, ce qui pose problème selon la taille de l’échantillon étudié. Le MSLQ, grâce à sa méthodologie quantitative, permet de récolter rapidement des données, et ce, pour de plus grands échantillons. Cela peut ainsi favoriser la comparaison entre les participants et les contextes (ou cours spécifiques choisis).

Conclusion

En conclusion, le SRLIS et le MSLQ, bien que différents, se révèlent être des outils relativement complémentaires pour évaluer les stratégies d’apprentissage des apprenant.e.s et leur capacité d’auto-régulation. Ce travail a permis de mettre en pratique ces outils et donc d’identifier les forces et faiblesses de ceux-ci. Les résultats de ce travail ont pu montrer que les deux outils se montrent plutôt efficaces pour identifier les stratégies d’apprentissage mobilisées par les étudiant.e.s du niveau tertiaire. Toutefois, quelques pistes d’amélioration peuvent être proposées afin d’améliorer davantage l’efficacité de ces outils.

Afin de renforcer la validité des outils, nous pourrions proposer une adaptation des scénarios du SRLIS pour les étudiant.e.s du niveau tertiaire, tout en y incluant des descriptions plus précises pour éviter les incompréhensions comme celles relevées par les participant.e.s de ce travail. Pour le MSLQ, nous pourrions proposer une option « non applicable » pour les items du questionnaire ne correspondant pas au cours spécifique choisi.

Afin d’améliorer la fidélité des outils, nous pourrions repenser au codage du SRLIS en clarifiant davantage les conditions de catégorisation des stratégies, ou en effectuant des accords-interjuges. De plus, pour le MSLQ, nous pourrions adapter le questionnaire en une version plus courte de sorte à limiter la fatigue que les étudiant.e.s manifestent dans le questionnaire original. Enfin, en considérant les limites liées à l’échantillon restreint, il serait avantageux d’inclure des participants aux cursus académiques similaires et donc permettre une comparaison plus homogène, ou encore d’étendre l’étude à un plus grand nombre de participant.e.s.

[1] Une personne qui a entouré 1 aura donc après inversion un score de 7, et ainsi de suite.

[2] Les catégories élaboration, autorégulation métacognitive et buts intrinsèques présentaient une fiabilité insuffisante.

Liste des références

- Bandalos, D. L. (2018). Measurement theory and applications for the social sciences. The Guilford Press.

- Berger, J.-L. et Büchel, F. (2012). Métacognition et croyances motivationnelles : un mariage de raison. Revue française de pédagogie. Recherches en éducation, (179), 95‑128. https://doi.org/10.4000/rfp.3705

- Berger, J.-L. et Karabenick, S. A. (2011). Motivation and students’ use of learning strategies: Evidence of unidirectional effects in mathematics classrooms. Learning and Instruction, 21(3), 416‑428. https://doi.org/10.1016/j.learninstruc.2010.06.002

- Boekaerts, M. (1997). Self-regulated learning: A new concept embraced by researchers, policy makers, educators, teachers, and students. Learning and Instruction, 7(2), 161‑186. https://doi.org/10.1016/S0959-4752(96)00015-1

- Büchel, F. P. (1996). DELF – Un programme métacognitif destiné à la formation professionnelle des adolescents et jeunes adultes ayant des difficultés d’apprentissage. Dans A.-M Bess et K. Bernath (dir.), Quelles chances sur le marché du travail? A propos de la formation des formateurs de jeunes et adultes handicapés (Éditions SZH, p. 183‑213).

- de Araujo, J., Gomes, C. M. A. et Jelihovschi, E. G. (2023). The factor structure of the Motivated Strategies for Learning Questionnaire (MSLQ): new methodological approaches and evidence. Psicologia: Reflexão e Crítica, 36(38), 17. https://doi.org/10.1186/s41155-023-00280-0

- Flavell, J. H. (1979). Metacognition and cognitive monitoring: A new area of cognitive–developmental inquiry. American Psychologist, 34(10), 906‑911. https://doi.org/10.1037/0003-066X.34.10.906

- J. Borkowski, L. Chan, et N. Muthukrishna. (2000). A Process-Oriented Model of Metacognition: Links Between Motivation and Executive Functioning. Dans Issues in the measurement of metacognition (Lincoln : Buros Institute, p. 1‑41).

- Ménard, L., Legault, F., Nault, G., St-Pierre, L., Ben Rhouma, T., Dion, J.-S. et Meunier, H. (2010). La formation à l’enseignement au postsecondaire : ses composantes et ses effets sur la motivation des étudiant. Actes du Congrès international AREF 2010 (Actualité de la recherche en éducation et en formation). Genève, Suisse. https://plone.unige.ch/aref2010/communications-orales/premiers-auteurs-en-m/La%20formation%20a%20lenseignement.pdf/view

- Nelson, T. O. (1990). Metamemory: A Theoretical Framework and New Findings. Dans Psychology of Learning and Motivation (vol. 26, p. 125‑173). Elsevier. https://doi.org/10.1016/S0079-7421(08)60053-5

- Pintrich, P. R. (2004). A Conceptual Framework for Assessing Motivation and Self-Regulated Learning in College Students. Educational Psychology Review, 16(4), 385‑407. https://doi.org/10.1007/s10648-004-0006-x

- Pintrich, P. R., Others, A., Smith, D. A., Garcia, T. et Mckeachie, W. J. (1991). A Manual for the Use of the Motivated Strategies for Learning Questionnaire (MSLQ) (no 91-B-004). National Center for Research to Improve Postsecondary Teaching and Learning. https://eric.ed.gov/?id=ED338122

- Schunk, D. H. et Greene, J. A. (2017). Historical, Contemporary, and Future Perspectives on Self-Regulated Learning and Performance. Dans D. H. Schunk et J. A. Greene (dir.), Handbook of Self-Regulation of Learning and Performance (2e éd., p. 1‑15). Routledge. https://doi.org/10.4324/9781315697048-1

- Soemantri, D., Mccoll, G. et Dodds, A. (2018). Measuring medical students’ reflection on their learning: modification and validation of the motivated strategies for learning questionnaire (MSLQ). BMC Medical Education, 18(1), 10. https://doi.org/10.1186/s12909-018-1384-y

- Wang, F., Jiang, C., King, R. B. et Leung, S. O. (2023). Motivated Strategies for Learning Questionnaire (MSLQ): Adaptation, validation, and development of a short form in the Chinese context for mathematics. Psychology in the Schools, 60(6), 2018‑2040. https://doi.org/10.1002/pits.22845

- Zimmerman, B. J. et Pons, M. M. (1986). Development of a Structured Interview for Assessing Student Use of Self-Regulated Learning Strategies. American Educational Research Journal, 23(4), 614‑628. https://doi.org/10.3102/00028312023004614 Zimmerman, B. et Martinez-Pons, M. (1988). Construct Validation of a Strategy Model of Student Self-Regulated Learning. Journal of Educational Psychology, 80(3), 284‑290. https://doi.org/10.1037/0022-0663.80.3.284