1. Introduction

L’autorégulation et la métacognition sont les concepts phares de ce travail. S’intéresser à comprendre comment les étudiant·e·s procèdent pour réaliser différentes tâches, à la manière dont ils·elles apprennent et déterminer les stratégies utilisées pour atteindre un but, fait partie du travail que nous réalisons ici. Des instruments sur l’autorégulation et la métacognition sont testés afin de pouvoir en faire une analyse. Selon Zimmerman (2002), on cherche à expliquer les apprentissages gérés par soi-même par le biais de trois aspects : métacognitif, motivationnel et environnemental. Zimmerman décrit cette autorégulation comme cyclique, car elle est transformée, modifiée selon différents facteurs (personnels, comportements, environnements). Ce cycle est en perpétuelle évolution durant les actions d’apprentissage de l’apprenant·e. Des recherches en collaboration avec Bandura et Martinez-Pons (1992), ont pu démontrer que le sentiment d’auto-efficacité, tout comme la fixation d’objectifs, jouaient un rôle important dans les performances et réussites des élèves. Afin de permettre aux apprenant·e·s d’améliorer et de mieux contrôler leurs apprentissages, il est important que la métacognition (qui est la réflexion sur ses propres fonctionnements cognitifs) soit associée à l’autorégulation. En se référant aux propos de Doly (2006), la métacognition peut être définie de manière philosophique comme une pensée critique et réflexive, et d’une manière plus scientifique qui se veut être un processus favorisant les apprentissages, le transfert et la motivation. Pour qu’un·e apprenant·e soit métacognitif·ve[1] et pour qu’il·elle s’autorégule, un enseignement de ces concepts doit lui être transmis durant son parcours scolaire. Martin et al. (2001) s’appuient sur les travaux de Palacio-Quintin (1990) pour montrer l’importance que le questionnement exercé par l’enseignant·e peut avoir sur le développement des mécanismes d’autorégulation et métacognitifs. En favorisant les situations d’apprentissage dans lesquelles l’élève va devoir utiliser des stratégies et réfléchir à son fonctionnement, permettra à l’élève d’être plus performant·e.

Cette recherche vise à découvrir deux outils : SRLIS (Self-Regulated Learning Interview Schedule) et Thinking Aloud (pensée à voix haute), à les tester, analyser et interpréter les résultats. Ce travail se présente en quatre parties principales. La première est dédiée à l’outil SRLIS. La deuxième partie se penche sur l’outil Thinking Aloud. La troisième présente une comparaison des deux outils. Une conclusion proposant des pistes de réflexion constitue la quatrième partie.

2. Partie SRLIS

2.1 Description de l’outil

L’outil SRLIS (Self-Regulated Learning Interview Schedule) a pour objectif d’évaluer dans quelle mesure l’apprenant·e utilise des stratégies autorégulées pour contrôler ses propres efforts d’apprentissages. Selon la définition utilisée par Zimmerman et Martinez-Pons (1990), cet outil est un entretien structuré développé pour mesurer l’utilisation de 14 stratégies d’apprentissage autorégulé. L’outil SRLIS est composé de deux éléments : un premier qui constitue les stratégies d’apprentissage autorégulé et un deuxième contenant des contextes d’apprentissage. Selon Zimmerman et Pons (1986), les 14 stratégies répertoriées sont basées sur des recherches et des théories antérieures. Durant l’entretien, lorsque les stratégies d’autorégulation sont mentionnées par le sujet, elles sont évaluées de manière quantitative à l’aide d’une échelle visuelle de 4 points allant de « rarement » à « la plupart du temps ». Pour cette recherche, les stratégies répertoriées par Zimmerman et l’échelle ont été retravaillées. Les stratégies d’autorégulation ont été traduites en français et pour certaines regroupées quant à l’échelle de Likert, elle va de 1(de jamais) à 5 (toujours).

En plus des stratégies, Zimmerman et Martinez-Pons (1986) expliquent que des contextes d’apprentissage basés sur des entretiens pilotes ultérieurs ont également été retenus pour construire cet outil. Ces contextes ont également été traduits et préparés à être lus aux sujets.

2.2 Description de l’échantillon

L’échantillon est composé de deux étudiantes de première année, en Sciences de l’éducation au niveau master. La première étudiante, âgée de 32 ans, a étudié à la Haute école pédagogique puis a poursuivi avec un master en enseignement spécialisé. La deuxième étudiante, âgée de 23 ans, a étudié à la Haute école pédagogique.

2.3 Description de la méthodologie

Il s’agit d’une recherche qui utilise une approche structurée qui va guider le sujet à faire une réflexion sur ses pratiques autour de la planification, la mise en œuvre et la réflexion. L’entretien est enregistré et de type directif. Cet outil récolte des données quantitatives, cependant il est possible d’utiliser les données qualitatives récoltées durant l’entretien pour renforcer l’interprétations de certains résultats quantitatifs. L’objectif des analyses est de fournir une interprétation des entretiens en vue d’avoir une réflexion critique sur l’instrument.

Avant l’entretien, une brève explication sur le déroulement et une demande de consentement à ce que l’enregistrement puisse avoir lieu est faite ainsi que les modalités de confidentialité transmises. L’intervieweuse lit les six contextes qui sont illustrés par un exemple concret et traduit en français, afin d’être le plus significatif possible pour le sujet. Lors de l’entretien, l’intervieweuse lit le contexte, si la personne n’indique pas de stratégies, il est possible de formuler une relance telle que « Et si c’est plus difficile ? ». Si malgré la difficulté, la personne ne mentionne toujours pas de stratégie, l’intervieweuse passe au contexte suivant. Si la personne mentionne une ou des stratégies, l’intervieweuse lui demande à l’aide de l’échelle allant de 1 (jamais) à 5 (toujours) d’évaluer la cohérence de celle·s-ci.

2.4 Présentation des résultats

L’analyse des verbatims qui se trouve au tableau 1 a permis de mettre en avant les stratégies utilisées par les deux étudiantes, celles utilisées par une seule étudiante, telle que « la recherche d’aide sociale », et celles non mentionnées par les étudiantes telle que la « structuration de l’environnement ».

Tableau 1

Résultats des verbatims associés aux stratégies d’apprentissage autorégulées

L’analyse de la fréquence de cohérence des stratégies d’autorégulation mentionnées par les étudiantes est représentée par le tableau 2 pour une vision claire et globale des résultats.

Tableau 2

SRLIS : Fréquences des stratégies utilisées

Les résultats montrent que « la fixation d’objectifs et planification » sont jugés particulièrement importants. Ce qui pourrait montrer que le besoin d’avoir une planification concrète des tâches permet de structurer et réguler son travail. Les étudiant·e·s savent que la remise des travaux dans les délais est une exigence de réussite. Nous pouvons faire l’hypothèse que cette stratégie d’autorégulation fait partie de celles que les deux étudiantes vont privilégier car elles la considèrent comme favorisant leur réussite. L’interprétation de ces résultats peut être renforcée avec les verbatims cités en lien avec ces stratégies tels que « noter ce que je dois faire », « avoir une vue globale », « estimer combien de temps ». D’autres résultats en lien avec « les conséquences personnelles » et « tenue de registres et suivi » sont intéressants. Ces deux stratégies d’autorégulation ne sont pas souvent citées dans les contextes mais quantifiées de manière élevée avec un 4 et 5. Nous pouvons donc émettre l’hypothèse que la fréquence de l’utilisation d’une stratégie n’est pas en lien avec l’importance qu’elle représente pour ces deux étudiantes.

Nous trouvons pertinent de ressortir l’aspect complémentaire que peuvent avoir les données qualitatives dans l’interprétation de nos résultats avec cette situation concernant la stratégie « la demande de l’aide sociale ». Par exemple, l’étudiante 2 mentionne l’aide de l’enseignant, un élément qu’elle a évalué à 2. Sans la partie qualitative, ce résultat pourrait questionner ou attirer l’attention de la chercheuse. Par le biais des données qualitatives, nous pouvons expliquer ce faible résultat : l’étudiante essaie, dans un premier temps, de répondre à ses questions par elle-même en mettant en place la stratégie de « recherche d’informations ». En outre, lorsque cette stratégie n’est pas auto-évaluée efficacement, elle utilise « la demande de l’aide sociale ». Ce qui explique le résultat de cette stratégie, mais également les liens que l’on peut retrouver dans l’utilisation des stratégies d’autorégulation.

Ces résultats montrent également que les deux étudiantes n’utilisent pas forcément les mêmes stratégies selon les contextes. En effet, une des étudiantes mentionne à plusieurs reprises des stratégies de « répétition et mémorisation » alors que l’autre pas du tout. Nous pouvons également relever que l’environnement et l’autoévaluation n’ont pas été mentionnés ni par l’une ni par l’autre. Si l’environnement et l’autoévaluation n’ont pas été mentionnées explicitement dans les contextes lus, c’est sans doute parce que les sujets n’ont pas pensé aux stratégies liées à ces aspects. Néanmoins, nous ne pouvons pas pour autant affirmer qu’elles n’utilisent pas l’une ou l’autre de ces stratégies.

2.5 Discussion sur l’outil de mesure

Cet outil de mesure n’a pas posé de problème majeur lors de la passation. Les aspects qualitatif et quantitatif de cet outil sont, quant à eux, très intéressants et permettent une complémentarité pour l’interprétation des résultats. Nous pensons que cela renforce sa validité et sa fiabilité dans l’interprétation des résultats. Le fait que le·la chercheur·se lise les contextes d’apprentissage et mène l’entretien permet au sujet de se concentrer uniquement sur ses réponses. Le·la chercheur·se doit rester concentré·e sur les propos des sujets et avoir les stratégies d’autorégulation en tête pour demander au sujet d’évaluer leur cohérence sur l’échelle de Likert. L’anticipation de la mise en place de l’entretien nous semble nécessaire pour que le·la chercheur·se puisse obtenir un maximum de données et puisse faire des liens pertinents par la suite entre les résultats qualitatifs et quantitatifs.

Une limite que nous relevons se situe au niveau des contextes d’apprentissage autorégulé. Dans la version de Zimmerman et Martinez-Pons (1990), huit contextes sont proposés aux étudiants dont un contexte en lien avec l’environnement, ce qui n’est pas le cas dans nos documents. Nous pouvons faire l’hypothèse que si ce huitième contexte[2] avait été lu aux sujets, elles auraient commenté une stratégie liée à la structuration de l’environnement. Nous supposons par ailleurs que ce n’est pas parce que la stratégie n’est pas explicitée qu’elle n’est pas utilisée. Dans certains cas spécifiques toutefois, nous émettons des doutes quant à la fiabilité et la validité de l’outil, notamment lorsqu’un sujet doit faire appel à des souvenirs qui ne reflètent pas toujours la réalité. Dans certains contextes, des stratégies étaient mentionnées par un sujet mais pas par l’autre. Nous pensons également que les contextes proposés (pas toujours adaptés au niveau académique des sujets) ont fixé des limites à l’entretien qui ont pu restreindre le développement des stratégies d’autorégulation utilisées par les sujets. Comme tout outil, il est important que le·la chercheuse soit attentif·ve aux différents biais liés aux sujets comme la disponibilté ou la capacité à s’auto-évaluer. Pour renforcer la validité de cet outil, nous proposons qu’un accord inter-juge soit mis en place lors du traitement des données. Nous supposons qu’à l’aide de cet outil, un·e chercheur·se peut obtenir des résultats sur une utilisation générale des stratégies d’autorégulation par les sujets.

3. Partie Thinking Aloud

3.1 Description de l’outil

L’outil Thinking Aloud ou “pensée à voix haute » consiste à demander aux participant·e·s d’exprimer à voix haute ce qu’ils·elles font durant l’accomplissement d’une tâche afin d’analyser et comprendre leurs processus d’apprentissage autorégulé. En se basant sur les propos de Hu et Gao (2017), l’objectif est d’identifier les processus cognitifs et métacognitifs des apprenant·e·s. Étant donné que la personne s’exprime en même temps qu’elle réfléchit, exécute et résous la tâche, le·la chercheur·se va adopter essentiellement un rôle d’observateur·trice. Cependant si l’apprenant·e devait arrêter de parler ou oublier d’indiquer sa démarche, le·la chercheur·se devra lui rappeler de formuler ses actions et pensées avec des relances du type : « A quoi penses-tu en ce moment ? S’il te plaît dit ce que tu penses ». Cet outil est considéré comme un dispositif précis par les chercheur·se·s comparé à une mesure rétrospective telle que le questionnaire par exemple. La réflexion à haute voix peut être influencée par différents facteurs tels que l’âge ou la tâche. Il est important que l’activité soit adaptée à l’apprenant·e pour que cet outil puisse être testé convenablement. Cette méthode va permettre de capturer une large palette de pensées ou processus cognitifs qui expliquent sur ce qui se passe véritablement dans la tête des sujets durant l’exécution de l’activité.

En plus d’une tâche à exécuter, la méthode Thinking Aloud doit être dotée d’un protocole prédéfini permettant l’analyse et l’interprétation des verbatims. Le protocole sera lié à l’objectif de la recherche. Selon Cheng et al. (2024) l’apprentissage autorégulé peut également se décrire par les trois phases cycliques de l’autorégulation de Zimmerman (2000). A travers ces phases, l’apprenant·e va contrôler, réguler sa cognition, sa motivation et son comportement afin d’atteindre au mieux les objectifs d’apprentissage fixés. Carré et Moisan (2002) éclaircissent les trois phases cycliques de Zimmerman de la façon suivante : 1) La phase de planification (analyse de la tâche et fixation de buts, basé sur les croyances automotivationnelles) ; 2) la phase de performance (l’utilisation de stratégies et d’auto-observation) ; 3) la phase d’autoréflexion (l’autojugement et l’auto-évaluation). Ce modèle de Zimmerman va permettre d’analyser nos résultats en lien avec l’objectif de cette recherche.

3.2 Description de la méthodologie

Il s’agit d’une recherche qui utilise une méthodologie qualitative car elle se base sur des entretiens non-dirigés enregistrés. L’objectif est de tester l’outil et mesurer les processus d’apprentissage autorégulé en analysant les verbatims selon les trois phases cycliques de l’autorégulation de Zimmerman (2000). Notre méthode Thinking Aloud est constituée d’une activité et d’un protocole pour l’analyse des résultats. Le thème de l’activité est une version simplifiée du jeu d’échecs et le protocole lié aux trois phases cycliques de l’autorégulation de Zimmerman. La durée de l’entretien est estimée à une dizaine de minutes et se fait avec les mêmes sujets que pour l’outil SRLIS. Avant l’entretien, une demande de consentement pour l’enregistrement est faite ainsi qu’un rappel sur les modalités de confidentialité. Ensuite, la chercheuse va expliquer le déroulement du test et demander au sujet d’exprimer à voix haute toutes ses pensées, ses sentiments, ses démarches durant l’exécution de la tâche. Une fois l’étudiante prête, la chercheuse va lui donner les documents de l’activité (consigne et feuille avec plateau de jeu), de quoi écrire et adopter un rôle d’observatrice. Durant tout l’entretien, la chercheuse reste attentive au comportement du sujet et prête à intervenir avec une relance en cas de besoin. Une fois que le sujet a terminé l’activité, l’entretien s’arrête.

3.3 Présentation des résultats

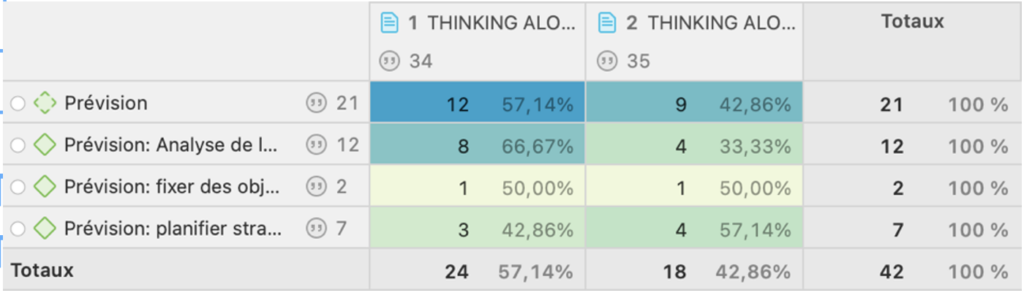

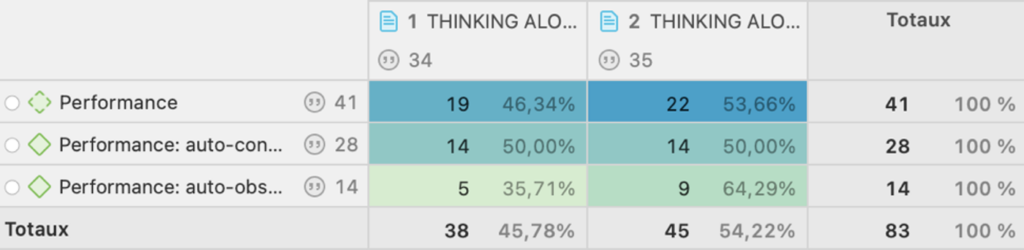

Afin d’analyser les verbatims des deux sujets, un codage (prévision, performance, autoréflexion) et sous-codage (avec les catégories des phases cycliques d’autorégulation) sont construits avec le logiciel ATLAS.ti. Nous avons fait un tableau permettant de visualiser plus précisément le nombre de verbatims liés à la catégorie principale et aux sous-catégories. Le tableau 3 répertorie les verbatims de « prévision », le 4 les verbatims de « performance » et le 5 les verbatims de « autoréflexion ».

Tableau 3

Résultats des verbatims répertoriés dans la phase prévision

Tableau 4

Résultats des verbatims répertoriés dans la phase performance

Tableau 5

Résultats des verbatims répertoriés dans la phase autoréflexion

Par ces tableaux, nous pouvons constater que les deux étudiantes se retrouvent le plus souvent dans la phase « performance ». De manière égal dans « l’auto-contrôle » et avec une légère différence dans « l’auto-observation ». Comme le décrit Zimmerman (2000) cette phase où l’apprenant·e surveille ses progrès, son niveau de compréhension en se posant des questions et ajuste ses méthodes, va renforcer l’efficacité de l’exécution. Les deux étudiantes ont exprimé des sentiments de doute comme : «Donc, je ne suis pas sûre si c’est…. », « Mais j’ai un petit doute… », « J’espère que ce n’est pas faux… », ces sentiments conduisaient régulièrement les étudiantes vers un retour aux règles. Nous pouvons dire que les étudiantes agissent de manière performante en ajustant et vérifiant leurs actions pour viser l’objectif fixé.

Dans un deuxième temps, en associant les verbatims aux comportements, nous pouvons dire que les deux étudiantes ne sont pas entrées de la même manière dans l’exécution de la tâche. L’étudiante 1 est restée plus longuement dans la phase « prévision », elle a analysé la tâche pour se fixer le bon objectif. Ce constat se justifie par le nombre de verbatims classés dans « analyse de la tâche » ainsi que par le sentiment de doute après la lecture de la consigne qui va la faire chercher à comprendre les conditions et les contraintes du jeu avant de passer à une action comme noter des éléments sur la feuille. Elle ne fait aucune allusion au jeu d’échecs. Nous pouvons faire l’hypothèse qu’elle ne connaît pas les règles du jeu d’échecs et n’arrive donc pas à faire des liens qui pourraient l’aider. Ce qui pourrait expliquer les difficultés rencontrées à la compréhension de l’activité. En revanche, l’étudiante 2, tout de suite après la lecture de la consigne, passe au marquage des rayons sur sa feuille pour visualiser les contraintes du jeu et mettre en place ses stratégies. Cela peut se confirmer par ces extraits : « Donc je vais essayer de tracer les rayons que je pense sur les cases… », « …mieux visualiser sur le plateau où est-ce que je peux placer mon pion blanc ». Elle fait également référence au jeu d’échecs « comme le fou » ce qui signifie qu’elle a fait un lien entre les deux activités. Nous pouvons faire l’hypothèse qu’elle a donc déjà joué aux échecs et qu’elle a tiré des leçons lors de parties précédentes et va adopter des stratégies pour atteindre efficacement son objectif.

Finalement, nos résultats indiquent que les deux étudiantes sont passées par la phase « auto-réflexion ». Même si elles possèdent le moins de verbatims répertoriés, on constate des processus liés à cette phase chez les étudiantes. Comme par exemple « le jeu est gagné. Je relis la règle, … », « Là, je contrôle en lisant les règles du jeu pour voir si j’ai bien fait juste,… », cette volonté de vérifier son travail et de pouvoir le valider ou le rectifier en cas de besoin signifie qu’il y a une réflexion autour des actions exécutées et nous hypothétisons que des remédiations seront apportées si elles devaient refaire ce jeu. Pour conclure, le fait que les étudiantes passent par les trois phases en continu durant l’exécution de la tâche montre que ces processus d’autorégulation sont bien interdépendants et cycliques comme le définit Zimmerman (2000).

3.4 Discussion sur l’outil de mesure

Cet outil de mesure demande une certaine structure afin de pouvoir obtenir des résultats utiles et fiables. Fixer les objectifs de la recherche et définir le type d’entretien que le·la chercheur·se souhaite réaliser sont des paramètres non négligeables. La flexibilité de cet outil peut être positive : le·la chercheur·se peut l’adapter facilement à ses sujets, aux objectifs de la recherche ; mais également négative : le·la chercheur·se doit être attentif·ve aux variables qui pourraient influencer le sujet ou compromettre la récolte de données fiables. Nous pensons que l’association des verbatims récoltés aux dimensions environnementales, comportementales et personnelles comme présenté par Zimmerman (2000) renforcent la validité de l’outil. Zimmerman (2000) rappelle que l’autorégulation dépend également de la confiance en soi et des réactions affectives.

Il ne suffit pas de demander à une personne d’exprimer à haute voix ce qu’elle accomplit ; un protocole prédéfini en lien avec les objectifs de recherche est essentiel pour que cet outil soit fiable et valide. En effet, comme le mentionne Hu et Gao (2017) des remises en question sur la véracité de certains protocoles pour saisir les processus cognitifs a déjà fait l’objet de discussions dans l’histoire de cet outil. Ce qui amène à la question de l’inter-juge. En effet, avoir plusieurs évaluateurs pour catégoriser les verbatims et vérifier la cohérence du protocole nous semble important afin d’obtenir des résultats fiables et de confirmer la validité de l’outil.

L’un des aspects positifs liés à cet outil concerne l’enregistrement. Celui-ci est utile aux chercheur·se·s lorsqu’il s’agit par exemple de mettre en place une démarche pour simplifier la résolution d’un problème. L’enregistrement profite également à l’apprenant·e, en tant que feed-back, car il lui permet de s’autoréguler et, in fine, d’être plus performant·e par la suite.

4. Comparaison entre les deux outils

Les trois points communs que nous ressortons de ces deux outils sont axés premièrement sur les domaines dans lesquels ils sont utilisés : l’éducation et la psychologie, deuxièmement sur ce qu’ils tentent de comprendre : l’autorégulation de l’apprentissage des individus, et troisièmement sur la méthode par entretien. Cependant, la manière de répondre diffère d’un outil à l’autre. Avec l’outil SRLIS, le sujet répond à des contextes proposés et doit évaluer la fréquence des stratégies utilisées ; les données obtenues sont quantitatives. Avec l’outil Thinking Aloud, le sujet verbalise « comment » il·elle résout la tâche tout en l’exécutant ; des données qualitatives sont récoltées. L’objectif visé par les deux outils n’est pas identique. SRLIS vise à évaluer dans quelle mesure l’apprenant·e utilise des stratégies autorégulées pour contrôler ses apprentissages dans des contextes spécifiques. Thinking Aloud, lui, vise à comprendre comment l’apprenant·e réfléchit et entreprend une tâche afin d’obtenir des indications sur ses stratégies et processus cognitifs.

L’outil SRLIS demande au sujet de faire appel à sa mémoire pour répondre aux contextes, nous sommes dans un entretien rétrospectif, alors qu’avec le Thinking Aloud les données sont récoltées au moment même de l’action. Ce qui peut donner une différence sur la fiabilité de l’outil. Nous pouvons émettre l’hypothèse que si la personne doit rechercher dans sa mémoire pour répondre à un contexte donné, les résultats obtenus peuvent être considérés comme moins fiables que dans le cas où la personne transmet sur le moment même. Une dernière comparaison peut se faire en lien avec le type de sujet à tester. Nous pensons que les différentes manières dont on peut mener Thinking Aloud permet de pouvoir l’adapter à une plus grande variété de la population. Chose que nous estimons plus complexe avec l’outil SRLIS où le sujet doit avoir un certain niveau de compréhension pour participer au test.

5. Conclusion

L’utilisation, l’analyse et la comparaison de ces deux outils, nous ont permis d’exercer cette tâche de chercheuse. A travers cette expérience, nous ressortons quelques éléments en lien avec le rôle du·de la chercheur·se qui peuvent avoir un impact sur les résultats. Pour le SRLIS, l’indécision des sujets à mesurer la fréquence d’une stratégie utilisée, ou l’incohérence entre l’explication de l’utilisation de la stratégie et la notation de sa fréquence, ont amené la chercheuse à devoir faire des choix sans être toujours convaincue qu’ils étaient les bons. Pour le Thinking Aloud, les sujets souhaitaient s’assurer de la bonne compréhension de la consigne en posant des questions, si la chercheuse avait répondu, les données auraient été biaisées. Garder cette position d’observatrice et de régulatrice (avec les relances seulement si nécessaire) peut être difficile car le·la chercheur·se doit également pouvoir mettre à l’aise le sujet pour un bon déroulement et éviter des situations de stress. Nous pensons que pour l’outils SRLIS l’importance de l’adaptation des contextes à l’échantillon testé fait partie des conditions pour la fiabilité du test, tout comme avoir un échantillon assez grand et varié. Nous soulignons donc l’importance de l’accord inter-juge pour les deux outils. Les données récoltées devraient être traitées au minimum par deux chercheur·se·s afin que les résultats pour l’outil SRLIS puissent être considérés comme plus fiables et de même que pour l’outil Thinking Aloud avec en plus de la fiabilité des résultats, la validité du protocole utilisé. Nous relevons que l’outil Thinking Aloud peut être directement utile aux apprenant·e·s car ils·elles pourraient utiliser l’enregistrement comme un feed-back leur permettant d’améliorer leurs fonctionnements. Comparativement au SRLIS qui apporte des résultats uniquement sur ce qui est utilisé donc difficile à utiliser comme remédiations pour améliorer l’autorégulation de l’apprentissage. Ce sont deux outils différents mais nous nous questionnons sur une éventuelle complémentarité. Les différentes lectures de Doly (2006), Hu et Gao (2017), Zimmerman (2000), démontrent l’importance du rapport entre l’enseignant·e et l’apprenant·e pour favoriser et améliorer l’autorégulation de l’apprentissage. Cela nous fait poser la question suivante : un·e élève habitué·e à utiliser des méthodes favorisant la réflexivité sur son fonctionnement – comme l’outil Thinking Aloud – est-il·elle plus enclin·e à utiliser des stratégies d’autorégulation ?

Il serait intéressant de poursuivre avec une recherche longitudinale qui irait dans le sens de cette question.

[1] Nous définissions l’adjectif métacognitif·ve comme être acteur·trice de ses apprentissages en utilisant des métaconnaissances judicieuses pour arriver à son but.

[2] Le huitième contexte rédigé par Zimmerman et Martinez-Pons (1990) demande aux étudiant·e·s s’ils·elles ont une méthode particulière pour aménager l’endroit/le lieu où ils·elles étudient.

6. Bibliographie

- Carré, I. P. et Moisan, A. (2002). Efficacité perçue et autorégulation des apprentissages durant les études: une vision cyclique Barry J. Zimmerman5.

- Cheng, G., Zou, D., Xie, H. et Wang, F. L. (2024). Exploring differences in self-regulated learning strategy use between high- and low-performing students in introductory programming: An analysis of eye-tracking and retrospective think-aloud data from program comprehension. Computers & Education, 208, 104948. https://doi.org/10.1016/j.compedu.2023.104948

- Doly, A.-M. (2006). La métacognition : de sa définition par la psychologie à sa mise en œuvre à l’école. Dans G. Toupiol (dir.), Apprendre et Comprendre. Place et rôle de la métacognition dans l’aide spécialisée, 84‑124. Retz. https://hal.science/hal-00835076

- Hu, J. et Gao, X. (2017). Using think-aloud protocol in self-regulated reading research. Educational Research Review, 22 (November 2017), 181‑193. https://doi.org/10.1016/j.edurev.2017.09.004

- Martin, D., Doudin, P., Albanese, O. (2001). Vers une pédagogie métacognitive. Dans PA Doudin, D. Martin, O. Albanese (dir.), Métacognition et éducation : aspects transversaux et disciplinaires (II Édition revue et augmentée (pp. 301-320).BERNE — CHE : ÉD. Pierre Lang. https://boa.unimib.it/handle/10281/16035

- Zimmerman, B. J. (2000). Chapter 2 – Attaining Self-Regulation: A Social Cognitive Perspective. Dans M. Boekaerts, P. R. Pintrich et M. Zeidner (dir.), Handbook of Self-Regulation (p. 13‑39). Academic Press. https://doi.org/10.1016/B978-012109890-2/50031-7

- Zimmerman, B. J., Bandura, A. et Martinez-Pons, M. (1992). Self-Motivation for Academic Attainment: The Role of Self-Efficacy Beliefs and Personal Goal Setting. American Educational Research Journal, 29(3), 663‑676. https://doi.org/10.3102/00028312029003663

- Zimmerman, B. J. et Martinez-Pons, M. (1990). Student Differences in Self-Regulated Learning: Relating Grade, Sex, and Giftedness to Self-Efficacy and Strategy Use, 82(1), 51‑59.

- Zimmerman, B. J. et Pons, M. M. (1986). Development of a Structured Interview for Assessing Student Use of Self-Regulated Learning Strategies. American Educational Research Journal, 23(4), 614‑628. https://doi.org/10.3102/00028312023004614